Mentre la modellazione del linguaggio occupa sempre più spazio nelle tecnologie AI, pensiamo che sia nostro dovere spiegare cos’è l’IA Chinchilla e come usarla ai nostri stimati lettori.

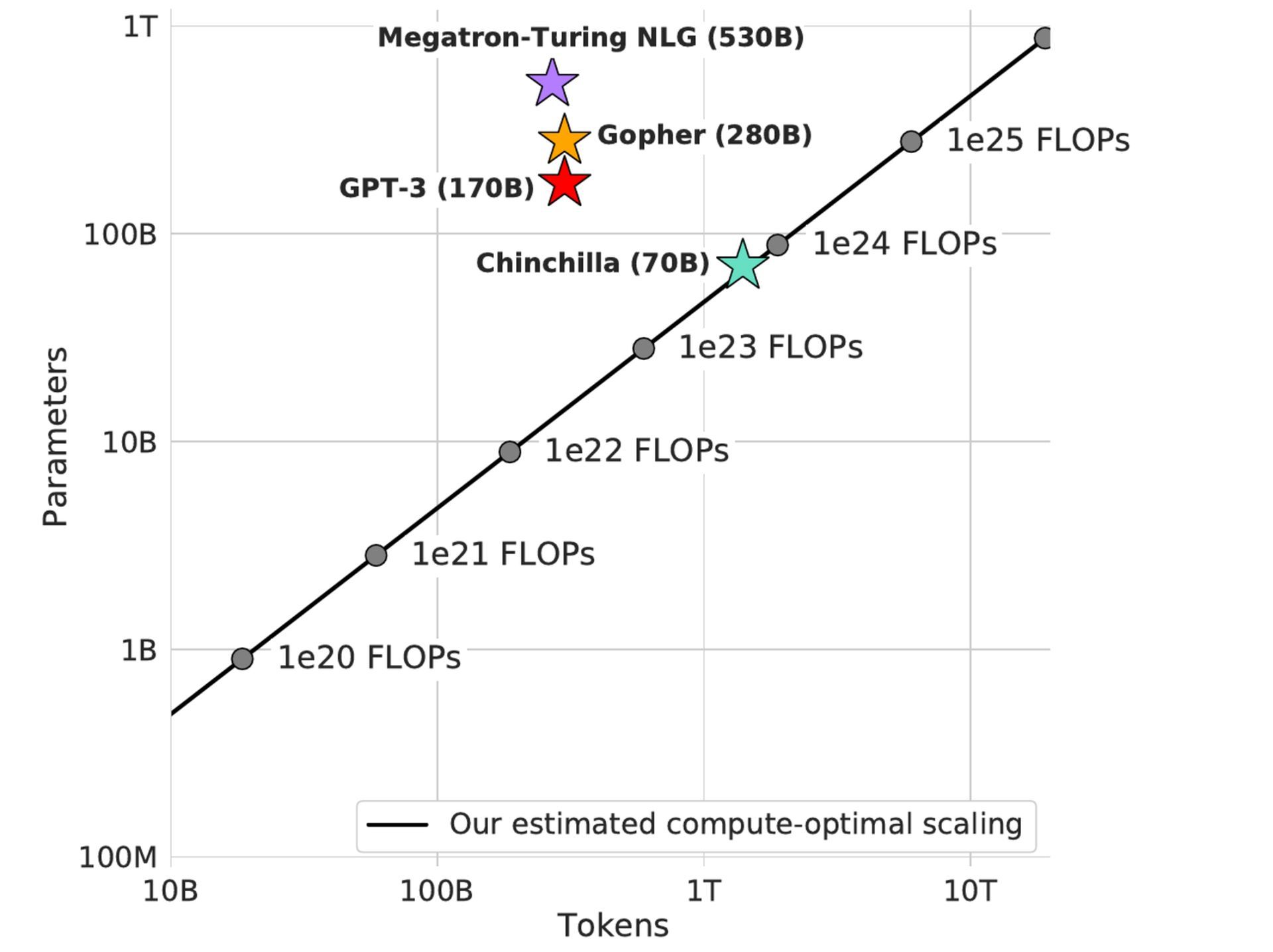

I ricercatori di DeepMind hanno creato il modello Chinchilla, che ha 70 miliardi di parametri e quattro volte più dati di Gopher ma lo stesso budget di calcolo. Le prestazioni di Chinchilla sono degne di nota non solo per la dimensione del miglioramento, ma anche perché è inferiore a qualsiasi altro modello linguistico principale creato nei due anni precedenti che ha dimostrato le prestazioni SOTA.

Chinchilla supera costantemente e in modo significativo Gopher (280B), GPT-3 (175B), Jurassic-1 (178B) e Megatron-Turing NLG in una varietà di attività di valutazione a valle (530B). Utilizza sostanzialmente meno calcolo per l’inferenza e la messa a punto, il che aumenta notevolmente l’utilizzo a valle. Ti chiedi cos’è l’IA di Chinchilla? Analizziamolo in questo articolo.

Cos’è l’intelligenza artificiale del cincillà?

Cominciamo col capire cos’è l’IA di Chinchilla prima di imparare a usare l’IA di Chinchilla. Le recenti sfide di modellazione del linguaggio tendono ad aumentare la complessità del modello senza aumentare il numero di token di apprendimento (circa 300 miliardi durante la formazione). Il modello di trasformatore più grande in questo momento è il Megatron-Turing NLG, che è più di tre volte più grande del GPT-3 di OpenAI. DeepMind ha presentato un nuovissimo modello linguistico chiamato Chinchilla.

C’è una differenza significativa, anche se funziona in modo simile a modelli di linguaggio di grandi dimensioni come Megatron-Turing NLG (parametri 530B), Jurassic-1 (parametri 178B), GPT-3 (parametri 175B), Gopher (parametri 280B) e GPT- 3: Con soli 70 miliardi di parametri e quattro volte più dati rispetto a Gopher, raggiunge una precisione media del 67,5% sul benchmark MMLU, che rappresenta un miglioramento del 7% rispetto a Gopher.

Come usare l’IA di Chinchilla?

Ora che ti abbiamo spiegato cos’è l’IA di Chinchilla, passiamo a rispondere alle tue domande su come usare l’IA di Chinchilla, ma abbiamo delle brutte notizie per te. Sfortunatamente, il pubblico in generale non può attualmente accedervi. L’intelligenza artificiale di Chinchilla sarà finalmente accessibile nei prossimi mesi, a quel punto potrai utilizzarla per sviluppare chatbot, assistenti virtuali, modelli predittivi e altre applicazioni di intelligenza artificiale.

Chinchilla ha raggiunto una precisione media all’avanguardia del 67,5% sul benchmark MMLU, superando Gopher del 7%. La strategia comune nella formazione del modello linguistico di grandi dimensioni è stata quella di costruire il modello senza aumentare l’offerta di token di formazione. Il più grande trasformatore denso, MT-NLG 530B, è ora più di tre volte più grande dei 170 miliardi di caratteristiche di GPT-3.

Chinchilla AI sarà una forza dominante nella modellazione del linguaggio

Ora che abbiamo risposto alla tua domanda Cos’è l’IA Chinchilla e come usarla, parliamo delle tecnologie AI in generale.

La crescita del modello senza aumentare il numero di token di addestramento è stato l’approccio prevalente nella formazione del modello linguistico di grandi dimensioni. Rispetto ai 170 miliardi di caratteristiche di GPT-3, il più grande trasformatore denso, MT-NLG 530B, è ora oltre 3 volte più grande.

La maggior parte dei modelli di grandi dimensioni attualmente in uso, incluso il Chinchilla di DeepMind, sono stati tutti addestrati per oltre 300 miliardi di token. La corsa all’addestramento di modelli sempre più grandi sta producendo modelli che, secondo i ricercatori, hanno prestazioni notevolmente inferiori rispetto a quanto si potrebbe ottenere con lo stesso budget di calcolo. Questo è vero anche se il desiderio di addestrare questi mega-modelli ha un’ingegneria notevolmente avanzata.

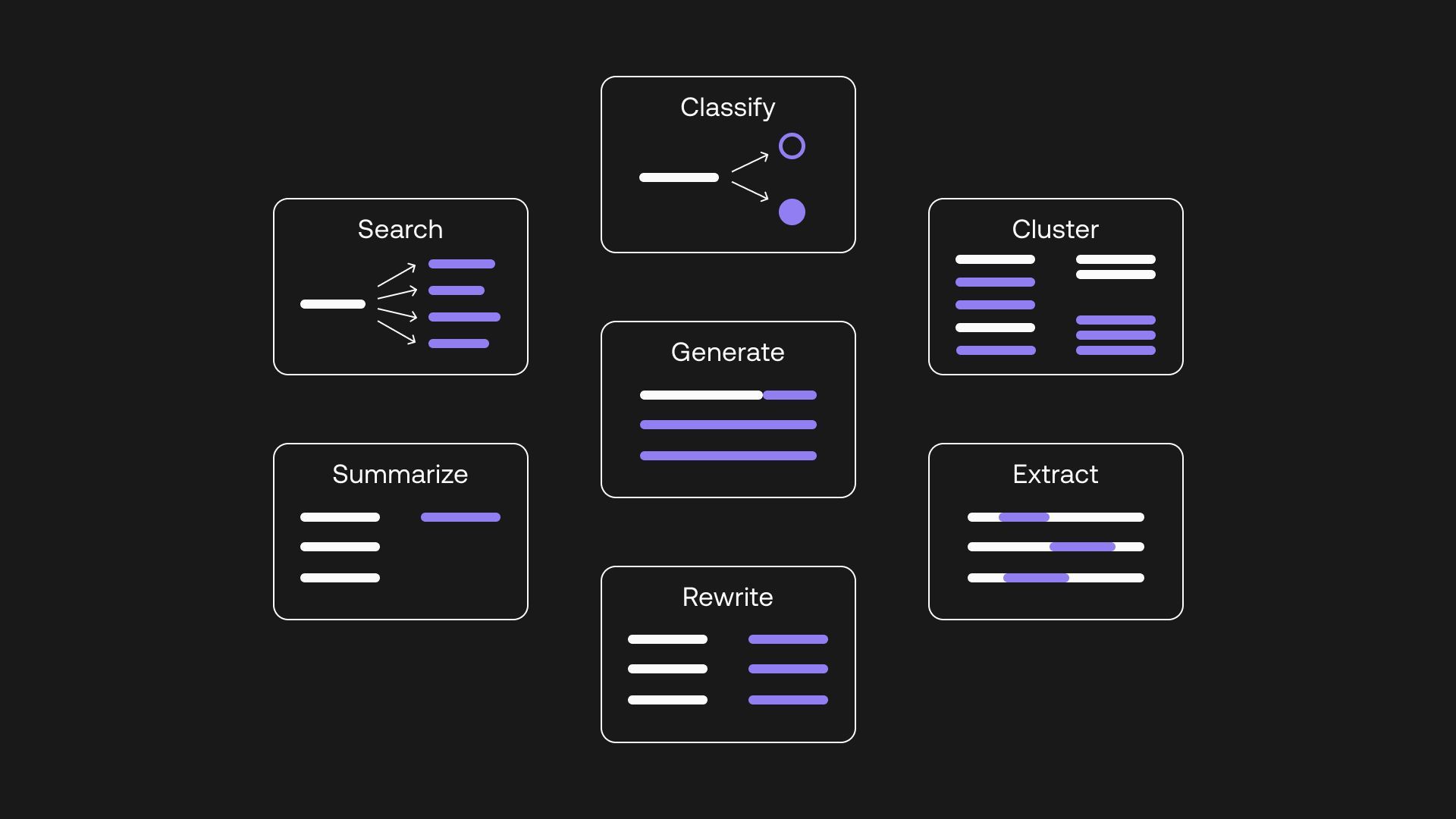

Funzionalità di Chinchilla AI che supereranno il budget di calcolo

Il fattore limitante nelle tecnologie AI è in genere il budget di elaborazione, che è indipendente e noto in anticipo. La quantità di denaro che l’azienda può spendere per un hardware migliore definirà in definitiva la dimensione del modello e il numero di token di addestramento. Per superare questo problema, le caratteristiche di Chinchilla AI:

- Dimensione del modello fissa: i programmatori di DeepMind hanno creato una famiglia di modelli di dimensioni fisse (70M-16B) e hanno regolato il numero di token di addestramento per ciascun modello (4 variazioni). È stata quindi identificata la migliore combinazione per ciascun budget di calcolo. Secondo questo metodo, un modello addestrato con la stessa quantità di potenza di calcolo di Gopher avrebbe 1,5 T di token e 67 B di parametri.

- Curve per isoFLOP: Gli ingegneri di DeepMind hanno sperimentato le dimensioni del modello e il budget di calcolo fisso. Questo metodo si tradurrebbe in un modello ottimale per il calcolo con 63 miliardi di parametri e 1,4 trilioni di token, addestrati con la stessa quantità di calcolo di Gopher.

- Creazione di una funzione di perdita parametrica: Gli ingegneri di DeepMind hanno modellato le perdite come funzioni parametriche della dimensione del modello e del conteggio dei token utilizzando i risultati dei metodi 1 e 2. Il modello ottimale per il calcolo addestrato utilizzando questo metodo avrebbe parametri 40B e la stessa quantità di calcolo di Gopher.

Se sei curioso, puoi esaminare l’approccio di DeepMind all’argomento dal documento che hanno pubblicato.

Stiamo arrivando alla fine del nostro articolo in cui abbiamo risposto alle domande su Cos’è l’IA di Chinchilla e come usarla nel miglior modo possibile per te. Mentre le tecnologie di modellazione del linguaggio sono riuscite a diventare la sottocategoria AI più importante nel 2022, ci chiediamo cosa ci aspetta nel 2023.

Source: Cos’è Chinchilla AI e come si usa?