Sulla base di suggerimenti di testo, MusicGen di Meta può creare brevi nuove composizioni musicali che sono facoltativamente allineate a una melodia esistente.

MusicGen è costruito su un modello Transformer, così come la maggior parte dei modelli linguistici utilizzati oggi. MusicGen prevede il segmento successivo di un brano musicale in modo simile a come un modello linguistico prevede le seguenti lettere in una frase. I ricercatori usano EnCodec di Meta tokenizer audio per suddividere i dati audio in parti più piccole. MusicGen è un approccio a fase singola rapido ed efficace che esegue l’elaborazione dei token in parallelo.

Per l’addestramento, l’equipaggio ha utilizzato 20.000 ore di musica autorizzata. Loro hanno usato 10.000 audio di alta qualità registrazioni da un set di dati interno, nonché dati musicali di Shutterstock e Pond5, in particolare.

MusicGen: Che cos’è?

Come la maggior parte dei modelli linguistici in uso oggi, MusicGen è costruito utilizzando un modello Transformer. Analogamente a come un modello linguistico prevede le lettere successive in una frase, MusicGen prevede la sezione successiva di un brano musicale.

I dati audio sono divisi in bit più piccoli utilizzando il tokenizer audio EnCodec di Meta dai ricercatori. MusicGen è un metodo a fase singola che elabora i token in modo rapido ed efficace in parallelo.

Insieme all’efficacia del design e alla velocità di produzione, MusicGen è eccezionale nella sua capacità di gestire sia il testo che i segnali musicali. La musica nel file audio segue lo stile di base stabilito nel testo.

Non puoi cambiare esattamente la direzione della melodia per ascoltarla, diciamo, in altri generi musicali. Serve solo come guida generale per la generazione e non è esattamente replicato nell’output.

Nonostante il fatto che molti altri modelli eseguano generazione di testo, sintesi vocale, immagini generate e persino piccoli film, non ci sono stati molti esempi di produzione musicale di alta qualità che sono stati resi accessibili al pubblico.

MusicGen: come si usa?

Gli utenti possono testare MusicGen utilizzando il API Abbracciare il viso, ma a seconda di quanti utenti lo utilizzano contemporaneamente, può essere necessario del tempo per produrre musica. Puoi creare la tua istanza del modello utilizzando il sito Web Hugging Face per risultati molto più rapidi. Puoi scaricare il codice ed eseguirlo tu stesso se disponi delle conoscenze e degli strumenti richiesti.

Ecco come provare la versione online se, come la maggior parte delle persone, vuoi:

- Lancio un browser web.

- Visita la pagina web per Volto che abbraccia.

- Scegli in alto a destra Spazi.

- Cercare “Gen musicale” nella scatola.

- Individua quello che Facebook pubblicato.

- Nella casella a sinistra, digita il tuo prompt.

- Scegliere “Creare”.

Questo è tutto ciò che devi sapere!

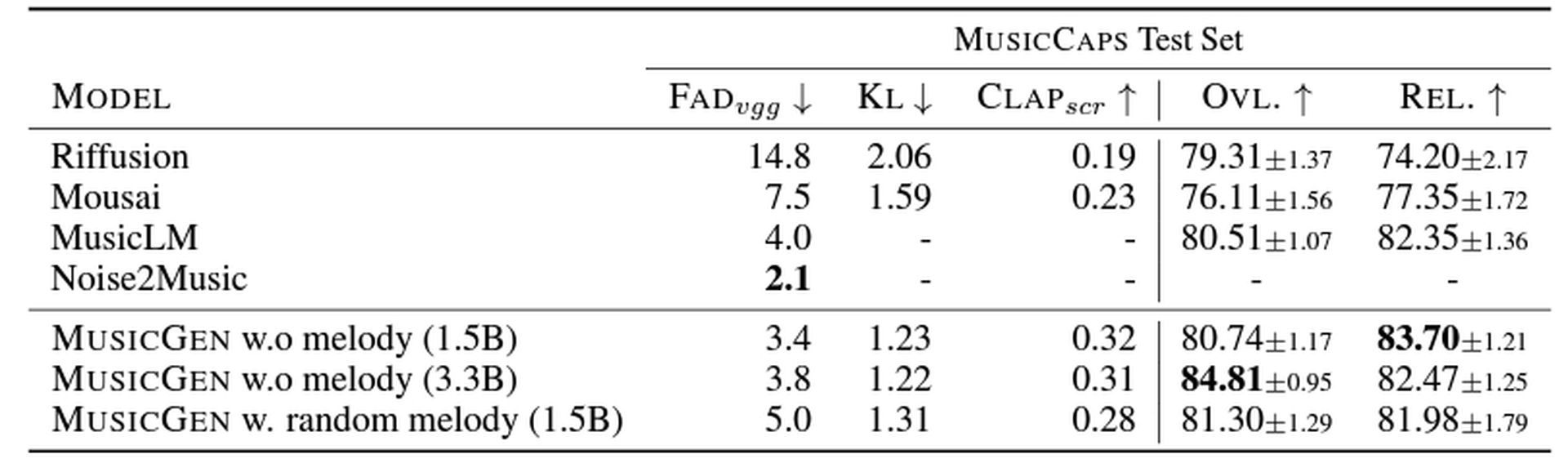

MusicGen batte MusicLM di un pelo

Tre dimensioni distinte del modello: 300 milioni (300 milioni), 1,5 miliardi (1,5 miliardi), E 3,3 miliardi (3.3B) — sono stati testati dagli autori dello studio. IL 1.5 miliardi il modello a parametri è stato giudicato il migliore dagli umani, ma hanno scoperto che i modelli più grandi generavano suoni di qualità superiore. D’altra parte, il 3,3 miliardi il modello di parametro funziona in modo più corretto quando si abbina l’input di testo con l’output audio.

MusicGen ottiene punteggi migliori su misure sia oggettive che soggettive che misurano quanto bene la musica corrisponda alle parole e quanto sia credibile la composizione rispetto ad altri modelli musicali come Riffusion, Mousai, MusicLM e Noise2Music. In generale, i modelli sono leggermente migliori del MusicLM di Google.

Il codice ei modelli sono stati resi disponibili da Meta come open source su Github e l’uso commerciale è consentito. C’è una demo in corso Faccia da abbraccio.

Sai cosa sono i link condivisi di ChatGPT?

Source: Cos’è MusicGen di Meta e come si usa? • TechIn breve