Conosci la storia delle tecnologie AI di cui si parla costantemente? Oggi ci addentreremo nell’argomento: “Da quanto tempo esiste l’IA?” assieme a te.

L’intelligenza artificiale (AI), un campo relativamente nuovo con circa 60 anni di storia, è una raccolta di scienze, teorie e metodi che cercano di replicare le capacità cognitive umane. Questi includono:

- Logica matematica

- Statistica, probabilità

- Neuroscienze computazionali

- Informatica

A partire dalla seconda guerra mondiale, i suoi progressi sono strettamente legati a quelli dell’informatica e hanno consentito ai computer di svolgere lavori sempre più complicati che in precedenza erano adatti esclusivamente agli esseri umani.

Da quanto tempo esiste l’IA?

Dal 1940, la frase di intelligenza artificiale (AI) è stata nelle nostre vite. Alcuni esperti trovano il termine fuorviante perché questa tecnologia è ancora lontana dalla vera intelligenza umana. Il loro studio non è ancora avanzato al punto da poter essere paragonato alle attuali conquiste dell’umanità. Sarebbero necessari progressi nella scienza fondamentale affinché l’IA “forte”, che è appena apparsa nella fantascienza, sia in grado di modellare il mondo intero.

Tuttavia, dal 2010, il settore ha visto un nuovo aumento di popolarità, principalmente a seguito di significativi progressi nella potenza di elaborazione del computer e nel facile accesso a grandi quantità di dati. Una comprensione obiettiva del problema è ostacolata da ripetute promesse e preoccupazioni su cui a volte si fantastica.

A nostro avviso, una breve rassegna della storia della disciplina può servire a inquadrare le attuali discussioni.

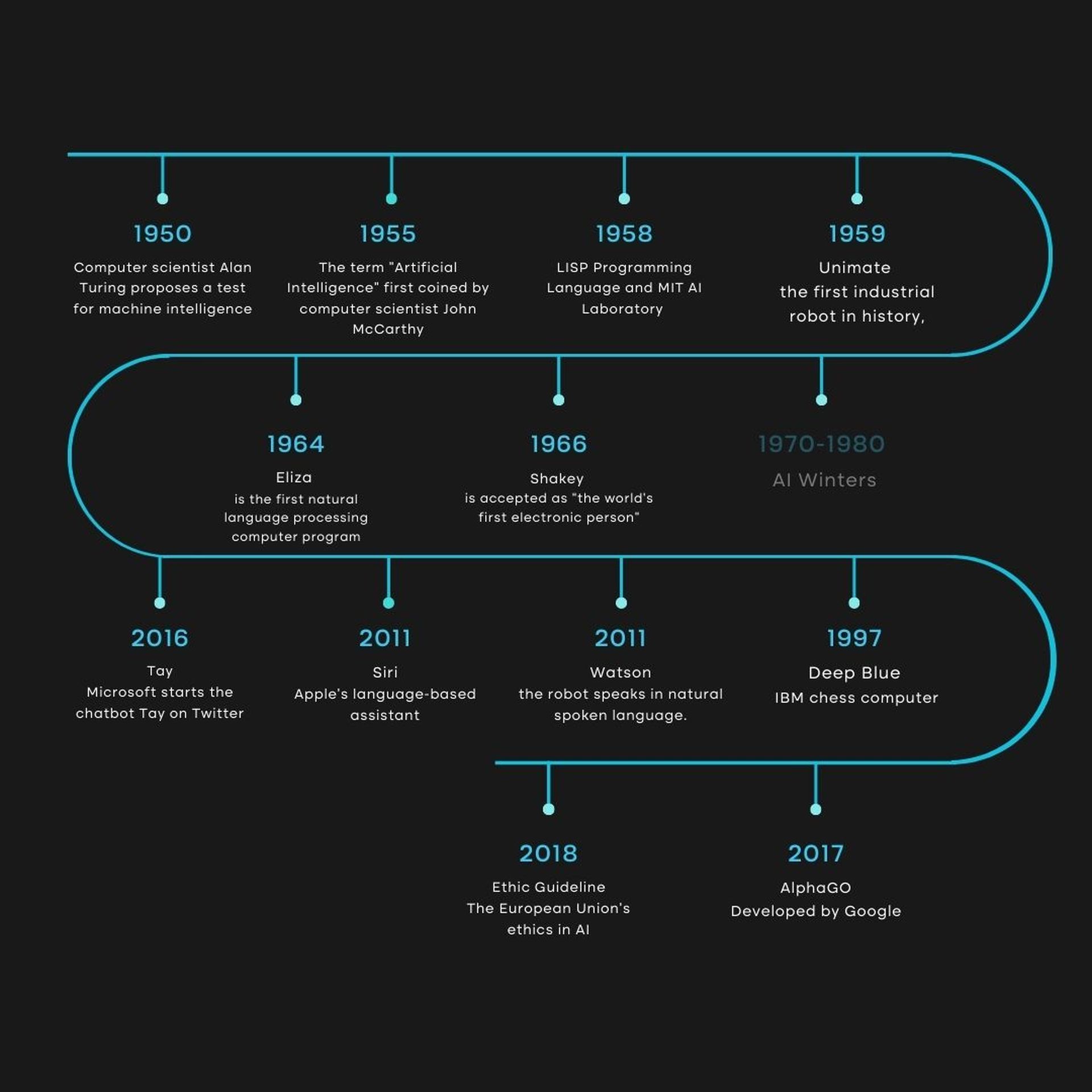

1940-1960: nascita di AI

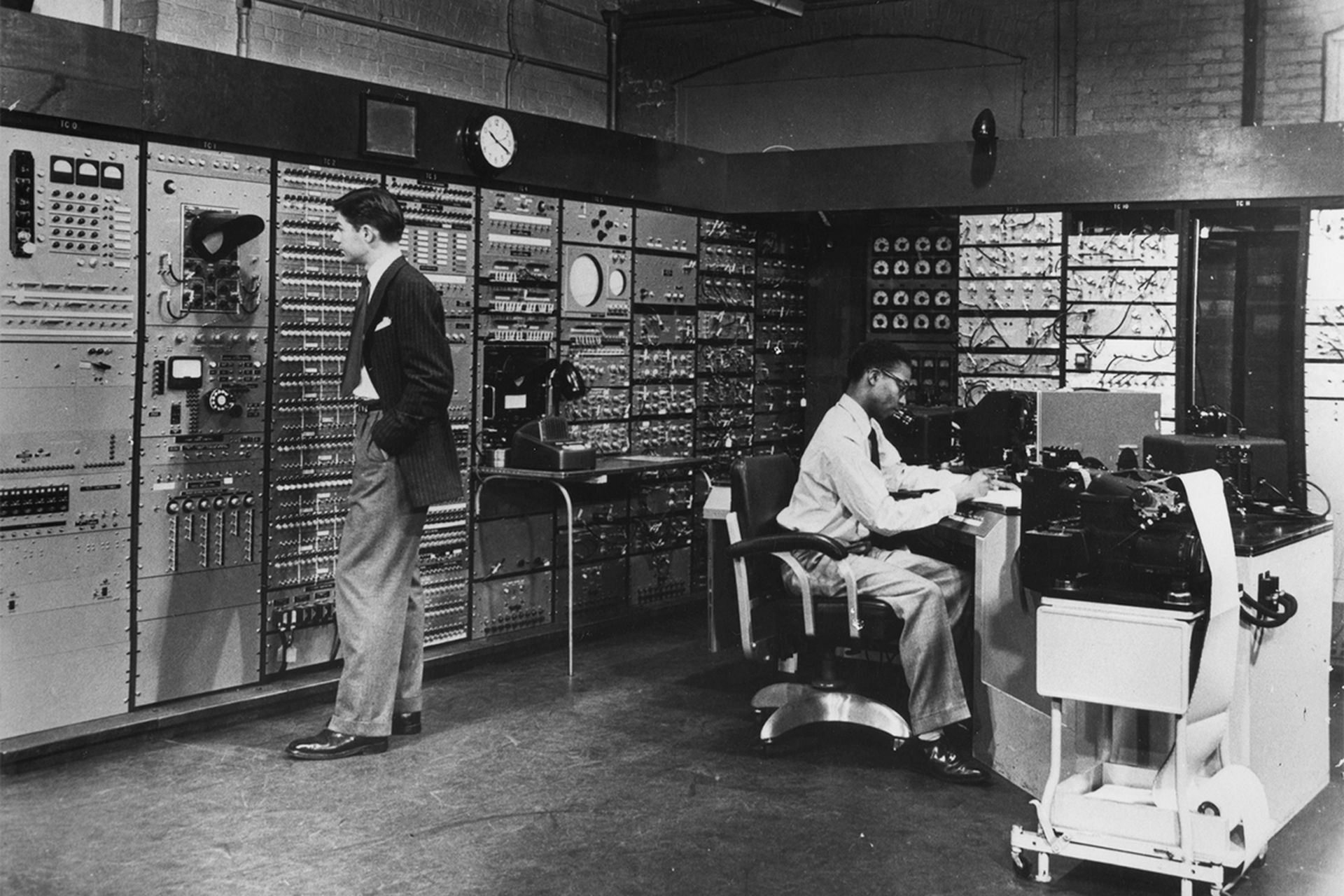

La confluenza dei progressi tecnologici e la ricerca di comprendere come combinare il funzionamento delle macchine e degli esseri organici tra il 1940 e il 1960 ha lasciato un’impressione duratura.

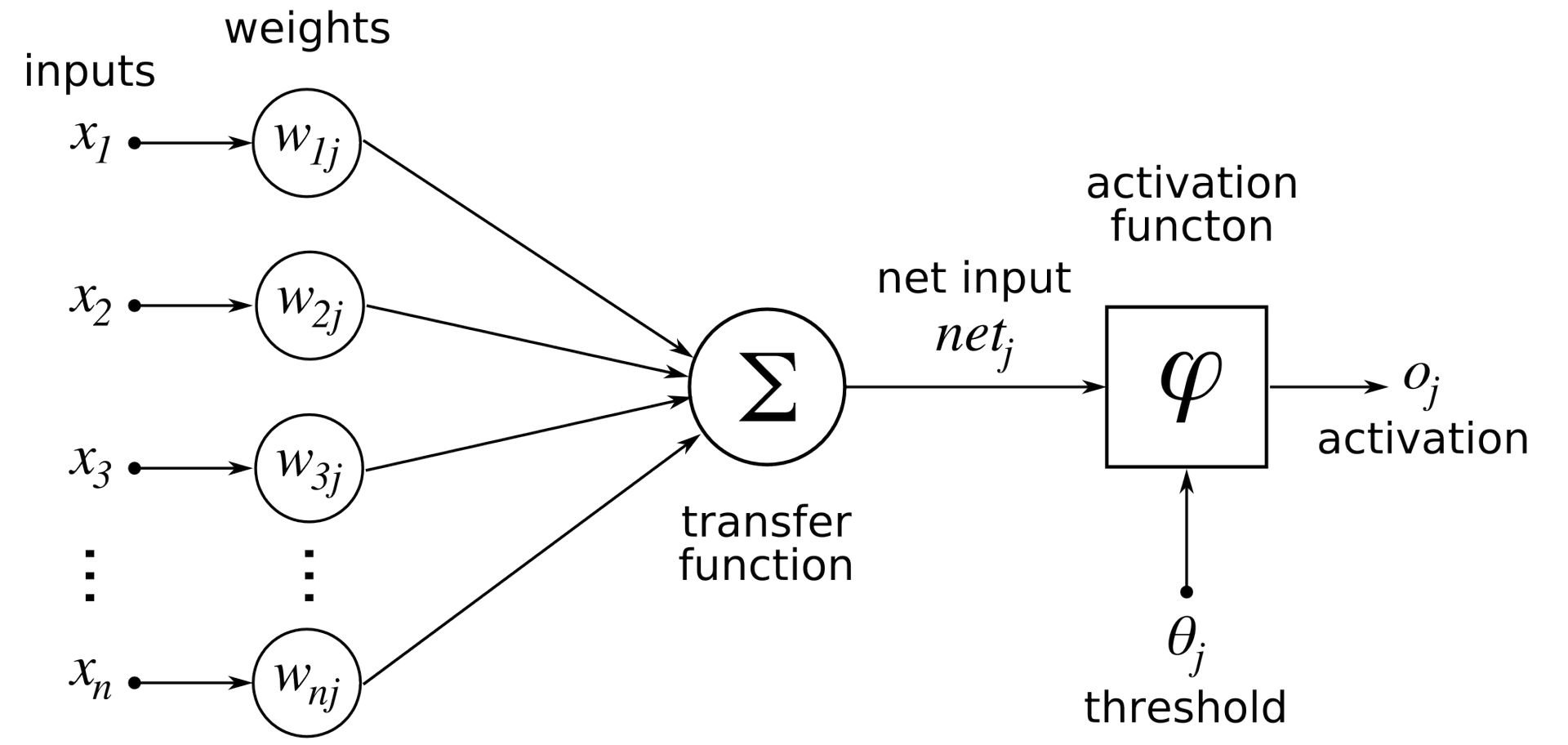

Per creare “un’intera teoria del controllo e della comunicazione, sia negli animali che nelle macchine”, Norbert Wiener, un pioniere nel campo della cibernetica, vide la necessità di integrare teoria matematica, elettronica e automazione. Prima di questo, Warren McCulloch e Walter Pitts hanno creato il primo modello matematico e computerizzato del neurone biologico nel 1943.

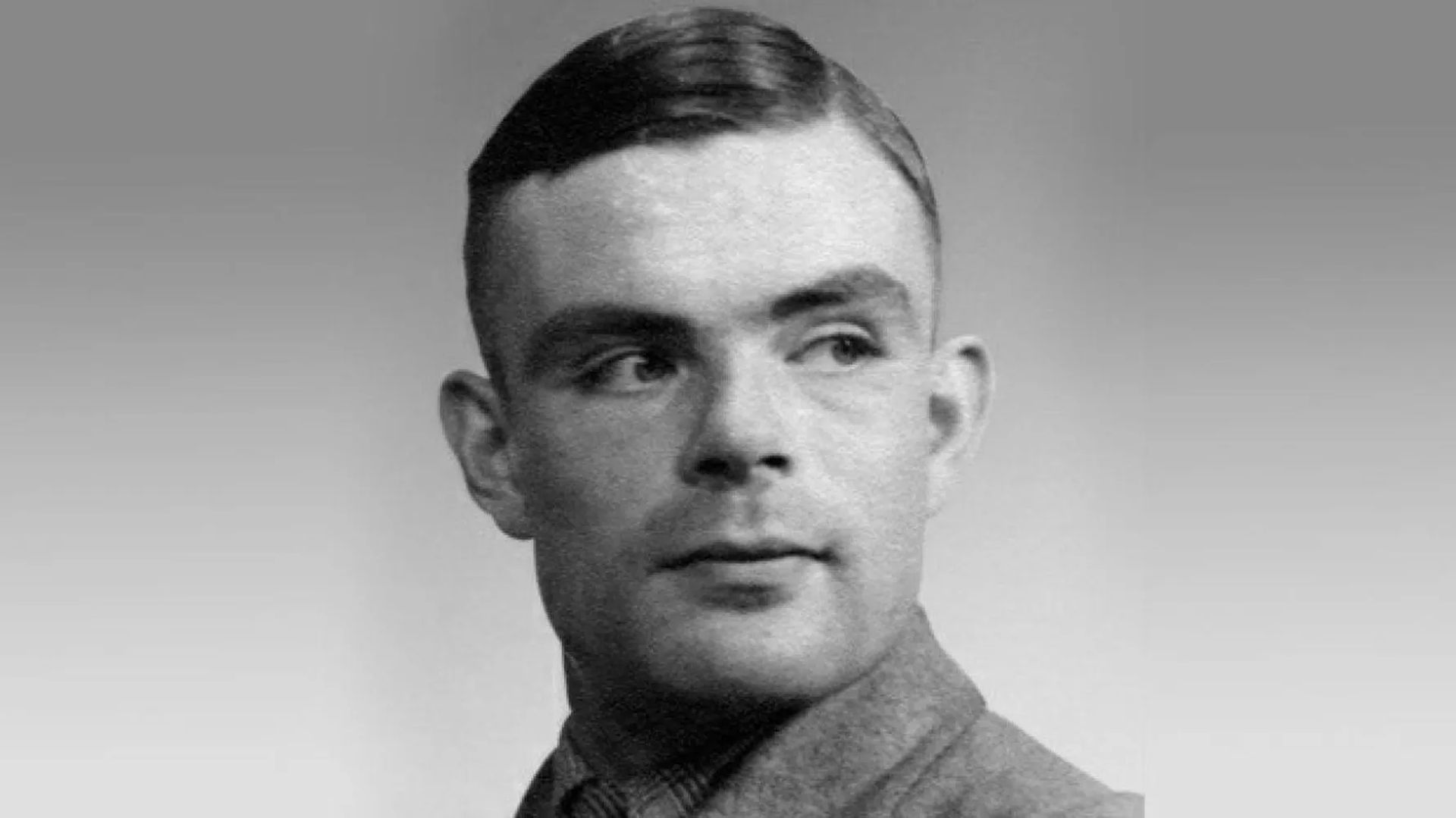

Sebbene non abbiano inventato il termine intelligenza artificiale (AI) all’inizio del 1950, John Von Neumann e Alan Turing sono stati i pionieri della tecnologia che ne è alla base. Hanno aiutato i computer a passare alla logica decimale del XIX secolo e le macchine alla logica binaria. Così, i due ricercatori hanno codificato l’architettura dei computer odierni e hanno dimostrato che si trattava di un dispositivo universale in grado di eseguire ciò che era programmato. Turing, d’altra parte, ha definito un “gioco di imitazione” in cui una persona dovrebbe essere in grado di dire in una conversazione telescrivente se sta parlando per la prima volta con un uomo o una macchina nel suo famoso articolo del 1950 “Computing Machinery and Intelligenza.”

Indipendentemente da quanto controverso possa essere, questo pezzo è spesso considerato il punto di partenza per discussioni su dove dovrebbe essere tracciata la linea di demarcazione tra umani e macchine.

John McCarthy del MIT è accreditato di aver inventato “AI”, che Marvin Minsky definisce come:

“Lo sviluppo di programmi per computer che si impegnano in compiti che attualmente sono meglio svolti dagli esseri umani perché richiedono processi mentali di alto livello come l’apprendimento percettivo, l’organizzazione della memoria e il ragionamento critico”.

Si attribuisce l’inizio della disciplina in un simposio tenutosi al Dartmouth College nell’estate del 1956. Aneddoticamente, è importante notare il seminario che è servito come evento principale della conferenza. McCarthy e Minsky erano due delle sei persone che hanno continuamente partecipato a questo sforzo.

I primi anni ’60 videro un declino dell’appeal della tecnologia, sebbene continuasse ad essere eccitante e promettente. A causa della scarsa quantità di memoria dei computer, l’utilizzo di un linguaggio informatico era impegnativo.

L’IPL, o linguaggio di elaborazione delle informazioni, aveva così reso possibile lo sviluppo del programma LTM, che tentava di mostrare teoremi matematici, già nel 1956. Tuttavia, c’erano anche alcuni fondamenti che sono ancora presenti oggi, come gli alberi di soluzione per risolvere teoremi matematici.

1980-1990: Sistemi esperti

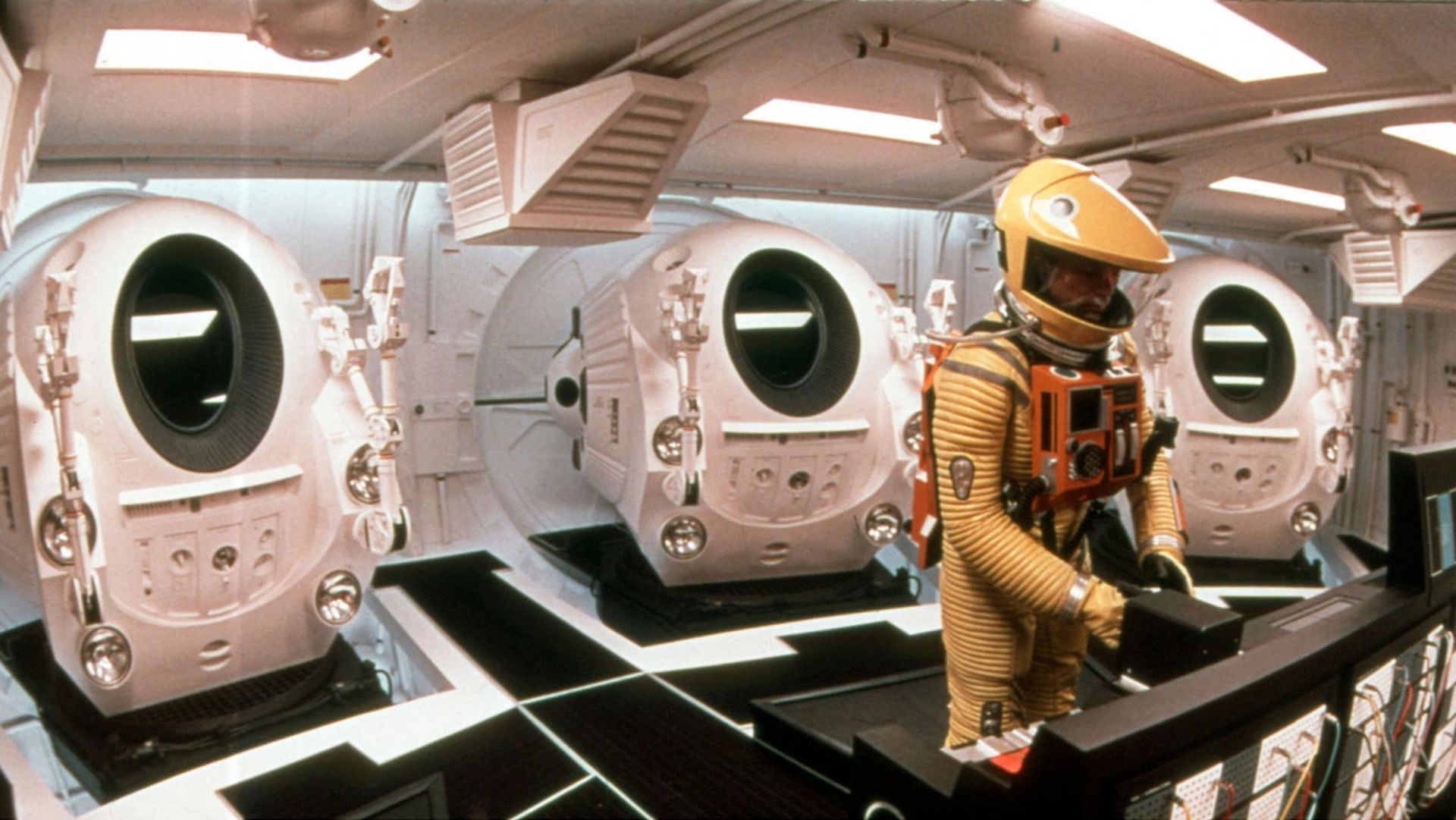

Il film del 1968 “2001 Space Odyssey”, diretto da Stanley Kubrick, presenta un computer chiamato HAL 9000 che racchiude tutte le preoccupazioni etiche sollevate dall’intelligenza artificiale:

“Sarà molto sofisticato, benefico per l’umanità o un pericolo?”

L’influenza del film ovviamente non sarà scientifica, ma contribuirà a rendere il tema più noto, proprio come il romanziere di fantascienza Philip K. Dick, che non smetterà mai di chiedersi se le macchine potranno mai provare emozioni.

I primi microprocessori furono introdotti alla fine del 1970 e i sistemi esperti entrarono nel loro periodo di massimo splendore quando l’intelligenza artificiale decollò ancora una volta. L’approccio è stato reso pubblico alla Stanford University nel 1972 con MYCIN e al MIT nel 1965 con DENDRAL. Questi sistemi si basavano su un “motore di inferenza”, costruito per essere una replica logica del ragionamento umano. Fornendogli informazioni, il motore ha prodotto risposte altamente informate.

Le promesse prevedevano un progresso significativo, ma entro la fine del 1980 o l’inizio del 1990 l’entusiasmo avrebbe raggiunto il picco. Ci è voluto molto lavoro per implementare tali informazioni e tra le 200 e le 300 regole si è verificato un effetto “scatola nera” che ha oscurato la logica della macchina. Pertanto, la creazione e la manutenzione sono diventate incredibilmente difficili e, cosa più importante, c’erano numerose altre opzioni disponibili, più veloci, meno difficili e più convenienti. Va ricordato che negli anni ’90 l’espressione “intelligenza artificiale” era quasi scomparsa dal vocabolario accademico e che erano addirittura arrivate forme più sommesse, come “informatica avanzata”.

Nel maggio 1997 il supercomputer Deep Blue di IBM vinse contro Garry Kasparov in una partita di scacchi, tuttavia, non incoraggiò il finanziamento e il progresso di questo tipo di intelligenza artificiale.

Deep Blue ha operato tramite un metodo metodico di forza bruta in cui tutte le potenziali mosse sono state soppesate e valutate. Sebbene Deep Blue fosse stato in grado di attaccare solo un’area relativamente piccola ed era ben lungi dall’essere in grado di simulare la complessità del globo, la sconfitta dell’umano rimase un evento estremamente simbolico nella storia.

2010-oggi: l’era moderna dell’IA

Le tecnologie AI, che hanno colpito i riflettori dopo la sconfitta di Kasparov contro il supercomputer Deep Blue, hanno raggiunto il picco a metà del 2010. Due fattori possono spiegare il nuovo boom della disciplina intorno al 2010:

- Accesso a enormi quantità di dati

- Scoperta di processori per schede grafiche per computer che funzionano a un’efficienza estremamente elevata

I risultati pubblici resi possibili da questa nuova tecnologia hanno aumentato gli investimenti e Watson, l’IA di IBM, sconfiggerà due campioni di Jeopardy nel 2011.

Un’intelligenza artificiale sarà in grado di identificare i gatti nei video nel 2012 grazie a Google X. Questa sfida finale ha richiesto l’impiego di oltre 16.000 processori, ma il potenziale di una macchina può imparare a distinguere tra cose diverse è stato sbalorditivo.

Nel 2016, Lee Sedol e Fan Hui, i campioni europei e mondiali di Go Games, avrebbero perso contro AI AlphaGO di Google.

Da dove ha avuto origine questo miracolo? Un allontanamento radicale dai sistemi esperti. La metodologia è cambiata per essere induttiva; invece di codificare le regole come nel caso dei sistemi esperti, è ora necessario consentire ai computer di scoprirle autonomamente attraverso la correlazione e la categorizzazione basata su grandi quantità di dati.

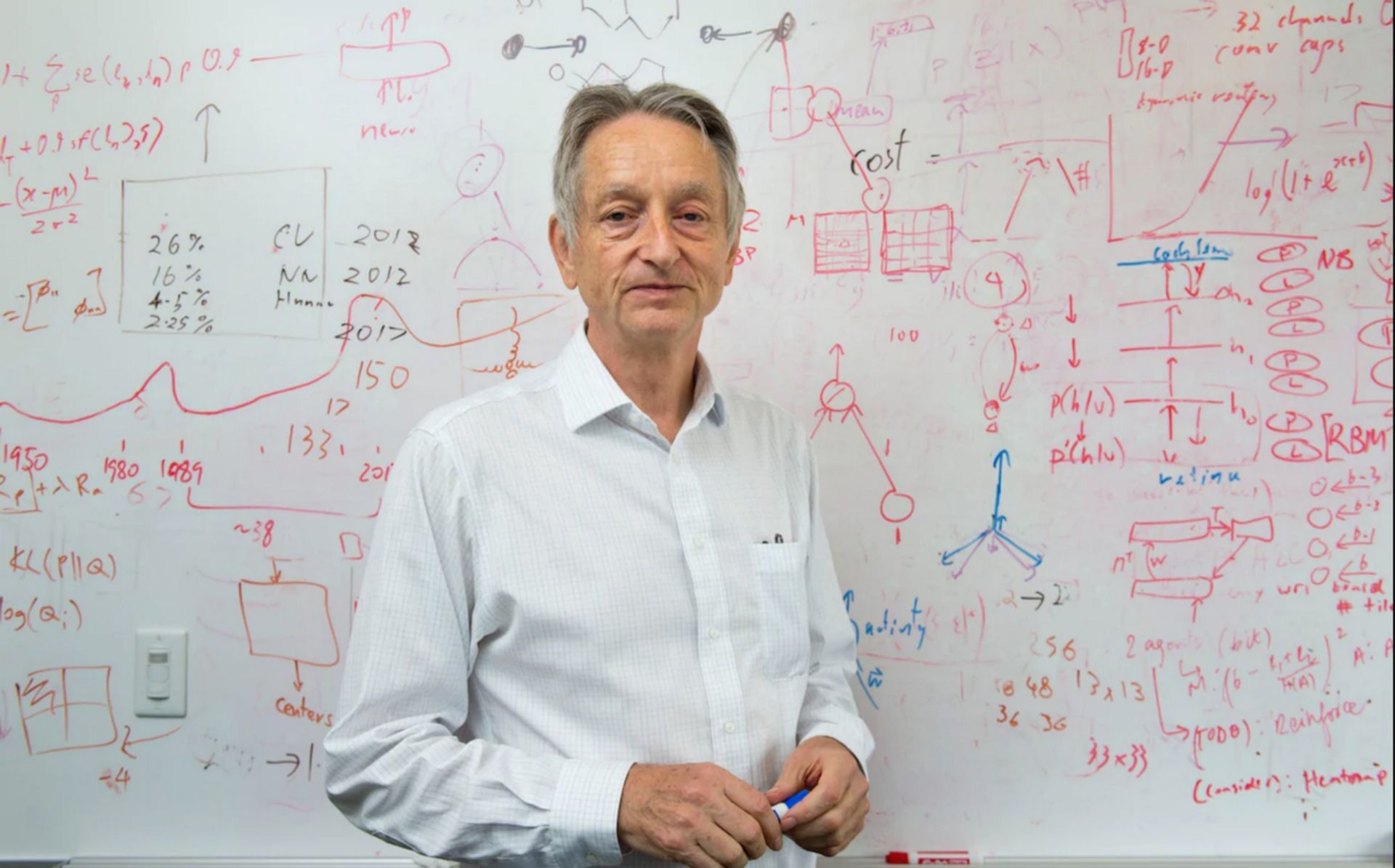

Il deep learning sembra essere la tecnologia di machine learning più promettente per una varietà di applicazioni. Geoffrey Hinton, Yoshua Bengio e Yann LeCun hanno deciso di lanciare un programma di ricerca nel 2003 per modernizzare le reti neurali. Con l’assistenza del laboratorio di Toronto, gli esperimenti condotti contemporaneamente a Microsoft, Googlee IBM ha rivelato che questo tipo di apprendimento ha avuto successo nel ridurre della metà i tassi di errore per il riconoscimento vocale. Il team di riconoscimento delle immagini di Hinton ha avuto un successo simile.

Quasi dall’oggi al domani, la stragrande maggioranza dei team di ricerca ha adottato questa tecnologia, che presentava innegabili vantaggi. Sebbene ci sia stato un miglioramento significativo nel riconoscimento del testo a causa di questa forma di apprendimento, c’è ancora molta strada da fare prima che possano essere creati sistemi di comprensione del testo, secondo specialisti come Yann LeCun.

Gli agenti conversazionali forniscono un buon esempio di questa difficoltà: mentre i nostri smartphone sono attualmente in grado di trascrivere le istruzioni, non sono in grado di contestualizzarle correttamente o discernere i nostri intenti.

Ecco come abbiamo riassunto per voi lo sviluppo delle tecnologie AI fino ad oggi. Continua a leggerci per non perdere le ultime novità sulle tecnologie AI come Notion AI e Meta Galactica AI

Source: Da quanto tempo esiste l’intelligenza artificiale: spiegata la storia dell’intelligenza artificiale