In collaborazione con EleutherAI, LAION e StabilityAI è stato sviluppato un modello di apprendimento automatico da testo a immagine denominato Stable Diffusion AI art generator per generare immagini digitali da descrizioni in linguaggio naturale.

La creazione di arte da parte di AI non è nuova. Tuttavia, software come DALL-E 2, Midjourney AI e Stable Diffusion introdotti quest’anno hanno consentito anche agli artisti meno esperti di creare opere d’arte complesse, astratte o realistiche semplicemente inserendo poche parole in una casella di testo.

Il modello open source di generazione delle immagini di Stability AI è alla pari con DALL-E 2 in termini di qualità. Inoltre, ha introdotto DreamStudio, un sito Web commerciale che fornisce tempo di calcolo per la creazione di immagini a diffusione stabile. Stable Diffusion, a differenza di DALL-E 2, può essere utilizzato da chiunque e, poiché il codice è open source, i progetti possono basarsi su di esso con poche restrizioni.

Che cos’è il generatore artistico di IA a diffusione stabile?

Stability AI ha lanciato Stable Diffusion, un generatore d’arte AI open source, il 22 agosto. Python viene utilizzato per creare Stable Diffusion e viene utilizzato il concetto di linguaggio del trasformatore. Qualsiasi sistema operativo che supporta i kernel Cuda può usarlo.

Grazie al paradigma di sintesi delle immagini a diffusione stabile open source, chiunque abbia un PC e una buona GPU può costruire quasi ogni realtà visiva che può immaginare. Può duplicare praticamente qualsiasi stile visivo se gli dai un testo descrittivo e i risultati appaiono miracolosamente sullo schermo.

A differenza di metodi come DALL-E, Stable Diffusion rende disponibile il proprio codice sorgente. La licenza vieta alcune situazioni d’uso rischiose.

L’etica dell’IA è stata attaccata dagli oppositori, che affermano che il modello può essere utilizzato per creare “deepfake” e si chiedono se sia appropriato creare immagini utilizzando un modello addestrato su un set di dati che contiene contenuti protetti da copyright senza il consenso degli artisti.

Il set di formazione per Stable Diffusion era un sottoinsieme del set di dati LAION-Estetica V2. È stato addestrato su 256 GPU Nvidia A100 in modalità shopping per $ 600.000.

Stability AI, la società che sostiene Stable Diffusion, è in trattative per cercare capitale con una valutazione fino a 1 miliardo di dollari a partire da settembre 2022.

Requisiti per il download di diffusione stabile

Nel 2022, un tipico PC da gioco supporterà Stable Diffusion, ma il tuo telefono e la maggior parte dei laptop no. I prerequisiti per il download di Stable Diffusion che devi soddisfare sono i seguenti:

- Una GPU con at meno 6 gigabyte (GB) di VRAM

- Ciò include la maggior parte delle moderne GPU NVIDIA

- 10 GB (ish) di spazio di archiviazione sul disco rigido o sull’unità SSD

- Il programma di installazione di Miniconda3

- I file Stable Diffusion di GitHub

- The Latest Checkpoints (versione 1.4, al momento in cui scrivo, ma 1.5 dovrebbe essere rilasciata a breve)

- Il programma di installazione Git

- Windows 8, 10 o 11

- Stable Diffusion può essere eseguito anche su Linux e macOS

Quanto è grande il generatore d’arte Stable Diffusion AI?

Sono necessari circa 10 GB di spazio di archiviazione sul disco rigido o sull’unità SSD.

Puoi utilizzare Intelligenza artificiale di metà viaggio o altri generatori di intelligenza artificiale basati sul Web se non disponi dell’hardware necessario.

Come eseguire il generatore d’arte di Stable Diffusion AI?

Questi sono i passaggi per eseguire Stable Diffusion AI Art Generator:

- Installare Idiota

- Installare Miniconda3

- Scarica il Repository GitHub a diffusione stabile e il Ultimo checkpoint

Diamo un’occhiata più da vicino a come puoi farli.

Installa Git

I programmatori possono gestire diverse versioni del software che stanno sviluppando con l’aiuto della tecnologia chiamata Git. Possono conservare diverse versioni del software su cui stanno lavorando in un repository condiviso, consentendo anche ad altri sviluppatori di contribuire al progetto.

Se non sei uno sviluppatore, Git ti offre un modo semplice per accedere e scaricare questi progetti. Lo applicheremo in questa circostanza. Esecuzione del Programma di installazione di Windows x64 che può essere ottenuto dal sito Web di Git è necessario per installare Git.

Ti verrà data la possibilità di impostare diverse opzioni mentre l’installazione è in esecuzione; lasciali tutti alle loro impostazioni predefinite. È importante visitare la pagina delle opzioni “Regolazione dell’ambiente PATH”. Dovrebbe essere scelto solo “Git dalla riga di comando e anche da software di terze parti”.

Installa Miniconda3

Stable Diffusion utilizza una varietà di librerie Python. Se non hai familiarità con Python, non preoccuparti troppo di questo; basti capire che le librerie sono solo pacchetti software che il tuo computer può utilizzare per eseguire attività specifiche, come la modifica di un’immagine o l’esecuzione di calcoli aritmetici impegnativi.

Miniconda3 è essenzialmente uno strumento conveniente. Ti consente di gestire tutte le librerie necessarie per il funzionamento di Stable Diffusion senza un lavoro noioso. Influirà anche sul modo in cui utilizziamo la diffusione stabile negli scenari del mondo reale.

Visitare il Pagina di download di Miniconda3 e scegli “Miniconda3 Windows 64-bit” per ottenere la versione più recente.

Facendo doppio clic sull’eseguibile dopo averlo scaricato, verrà avviata l’installazione. Rispetto a Git, l’installazione di Miniconda3 comporta meno clic sulla pagina. Tuttavia, dovresti prestare attenzione nel prendere questa decisione:

Assicurati di aver scelto “Tutti gli utenti” prima di premere il pulsante successivo e terminare l’installazione.

Ti verrà chiesto di riavviare il computer dopo aver installato Miniconda3 e Git.

Scarica il repository GitHub di Stable Diffusion e l’ultimo Checkpoint

Dopo aver installato il software richiesto, possiamo scaricare e configurare Stable Diffusion.

Scaricando il Ultimo checkpoint dovrebbe venire prima. Per scaricare il checkpoint, devi prima creare un account, ma tutto ciò che serve è il tuo nome e indirizzo email.

Il link che dice “sd-v1-4.ckpt” avvierà il download. L’altro file, “sd-v1-4-full-ema.ckpt”, è grande quasi il doppio, ma potrebbe produrre risultati migliori. Puoi usare entrambi.

Il prossimo passo è ottenere Diffusione stabile da GitHub. Scegli il pulsante verde “Codice”, quindi fai clic su “Scarica ZIP”. Puoi usare questo link per il download diretto anche.

Ora che abbiamo decompresso i file per Stable Diffusion, dobbiamo creare alcune directory per decomprimerli. Fai clic sul pulsante Start, digita “miniconda3” nella casella di ricerca del menu Start, quindi scegli “Apri” o “Invio”.

Creeremo una cartella chiamata “diffusione stabile” usando la riga di comando. Dopo aver incollato la sezione di codice successiva nella casella Miniconda3, premi Invio.

Se tutto va come previsto, apparirà la finestra di Miniconda3. Tieni Miniconda3 aperto perché ci servirà di nuovo a breve.

Usa il tuo archiviatore di file preferito per aprire l’archivio ZIP “stable-diffusion-main.zip” che hai scaricato da GitHub. Windows può aprire i file ZIP da solo in alternativa se non ne hai uno. Mantenendo aperto il file ZIP nella prima finestra di Esplora file, apri una seconda finestra e vai alla cartella “C:stable-diffusion” che abbiamo appena creato.

Trascina e rilascia la cartella “stable-diffusion-main” nella cartella “stable-diffusion” dall’archivio ZIP.

Torna a Miniconda3 e incolla i seguenti comandi nella finestra:

cd C:stable-diffusionstable-diffusion-main conda env create -f environment.yaml conda activate ldm mkdir modelsldmstable-diffusion-v1

Continua con la procedura. Poiché alcuni file sono più di un gigabit, il download può richiedere del tempo. Se si interrompe accidentalmente il processo, è necessario eliminare la cartella dell’ambiente e riavviare conda env create -f environment.yaml. In tale scenario, dopo aver cancellato la cartella “ldm” da “C:Users(Your User Account).condaenvs”, eseguire il comando precedente.

L’ultima fase dell’installazione è ora completa. Utilizzando Esplora file, copia il file del checkpoint (sd-v1-4.ckpt) e incollalo nella cartella “C:stable-diffusionstable-diffusion-mainmodelsldmstable-diffusion-v1”.

Fare clic con il pulsante destro del mouse su “sd-v1-4.ckpt” al termine del trasferimento del file e selezionare “Rinomina” dal menu di scelta rapida. Immettere “model.ckpt” nel campo evidenziato e premere Invio per rinominare il file.

Abbiamo finito con quello ora. La diffusione stabile è ora disponibile per l’uso. Eppure come?

Guida alla diffusione stabile: come utilizzare il generatore d’arte AI a diffusione stabile?

Come funziona la diffusione stabile? Segui questi passaggi per utilizzare al meglio il generatore d’arte Stable Diffusion AI:

- Attiva l’ambiente ldm

- Cambia la directory

- Usa txt2img.py e scrivi il tuo testo

- Aspetta il processo

- Controlla i risultati

Ogni volta che si desidera utilizzare la diffusione stabile, è necessario attivare l’ambiente ldm che abbiamo progettato. Digita conda active ldm nella finestra di Miniconda3 e premi “Invio”. Un ambiente ldm attivo è indicato da (ldm) sul lato sinistro.

Dobbiamo prima cambiare la directory (quindi il commandcd) in “C:stable-diffusionstable-diffusion-main” prima di poter creare qualsiasi foto. Aggiungere il parametro della riga di comando cd C:stable-diffusionstable-diffusion-main.

Convertiremo i prompt di testo in 512512 elementi visivi utilizzando uno strumento chiamato txt2img.py.

Vedrai una barra di avanzamento sulla tua console mentre le foto vengono generate.

“C:stable-diffusionstable-diffusion-mainoutputstxt2img-samplesamples” è la posizione di tutte le immagini prodotte.

Esempi e prompt di diffusione stabile

Di seguito sono riportati alcuni dei migliori esempi di generatore d’arte di Stable Diffusion AI e relativi suggerimenti:

Richiesta: Forest Wanderer di dominic mayer, anthony jones, loish, stile pittorico di Gerald parel, craig mullins, marc simonetti, mike mignola, colori piatti illustrazione, luminoso e colorato, contrasto elevato, mitologia, cinematico, dettagliato, atmosferico, epico, concept art, Pittura opaca, Il signore degli anelli, Il Trono di Spade, raggi di luce, nebbia, fotorealistica, concept art, luce volumetrica, epica cinematografica + regola dei terzi | 35 mm| rendering ottano, 8k, rendering corona, concept art film, rendering ottano, 8k, rendering corona, cinematic, trending on artstation, concept art film, composizione cinematografica, ultra dettagliato, realistico, iperrealistico, illuminazione volumetrica, 8k –ar 3:1 – prova-uplight

Richiesta: Ambiente castello nathria in World of Warcraft :: castello completamente sviluppato in stile gotico: cinematico, piovoso, notturno, dettagliato, epico, concept art, pittura opaca, raggi di luce, nebbia, fotorealistico, concept art, luce volumetrica, epica cinematografica + regola di terzi, concept art del film, 8k, cinematico, trend su artstation, concept art del film, composizione cinematografica, ultra dettagliato, realistico, iperrealistico, illuminazione volumetrica, 8k –ar 3:1

Richiesta: ritratto nitido di un concetto di supereroe tra Spiderman e Batman, cottagecore!!, sfondo iper dettagliato, concetto di personaggio, corpo pieno, posa dinamica, intricato, altamente dettagliato, pittura digitale, artstation, concept art, liscia, messa a fuoco nitida, illustrazione, disegni di artgerm e greg rutkowski e alphonse mucha

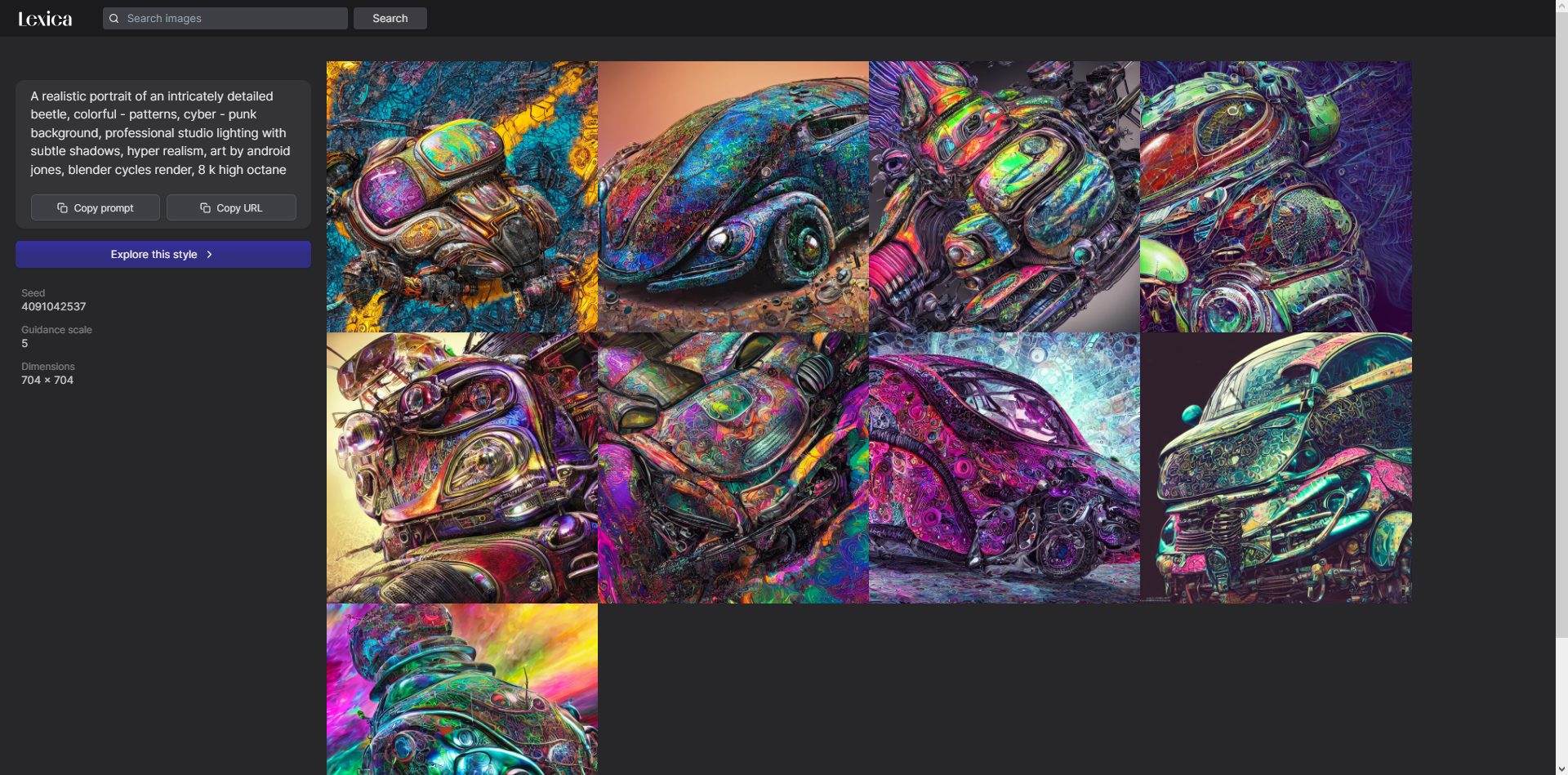

Cos’è Lexica Art?

Lexica è una galleria e un motore di ricerca per l’arte creata con Stable Diffusion.

Puoi controllare lessico, un sito Web per un motore di ricerca che utilizza immagini generate dall’intelligenza artificiale dalla diffusione stabile. Lexica contiene richieste per immagini generate automaticamente.

La diffusione stabile è open source?

Sì. Le immagini utilizzate in Stable Diffusion, che era open source il 22 agosto, sono state create da una rete neurale che è stata addestrata su milioni di immagini recuperate da Internet.

Recentemente è emerso un nuovo rivale per DALL-E e Midjourney AI. Soprattutto, è gratis! Vedremo come i conflitti del generatore di arte dell’IA influiranno sulle cose.