Un nuovo modello AI Meta ImageBind open source che collega molti flussi di dati, come testo, audio, dati visivi, letture di temperatura e letture di movimento, è stato reso pubblico da Meta.

Il modello è attualmente solo uno sforzo di ricerca senza consumatori immediati o applicazioni pratiche, ma suggerisce un futuro di generazione Sistemi di intelligenza artificiale in grado di produrre esperienze immersive e multisensoriali. Dimostra anche quanto apertamente Meta condivide ancora la sua ricerca sull’intelligenza artificiale in contrasto con concorrenti simili OpenAI E Googleentrambi diventati più solitari.

L’idea centrale dello studio è l’integrazione di diversi tipi di dati in un unico indice multidimensionale (o “incorporamento spazio,” usare Gergo AI). Anche se a questo punto potrebbe sembrare un po’ astratto, il concetto fondamentale alla base del recente aumento dell’IA generativa è lo stesso.

Cos’è Meta ImageBind AI?

Ad esempio, durante la fase di addestramento, un certo numero di generatori di immagini AI, tra cui DALLA–E, Stabile DiffusioneE A metà viaggio, fare affidamento su questi sistemi. Mettendo in relazione tali dati con le descrizioni delle foto, cercano schemi nei dati visivi. Ciò consente quindi a questi sistemi di produrre immagini che corrispondono agli input di testo da parte degli utenti. Numerose tecnologie AI producono anche video o audio in modo simile.

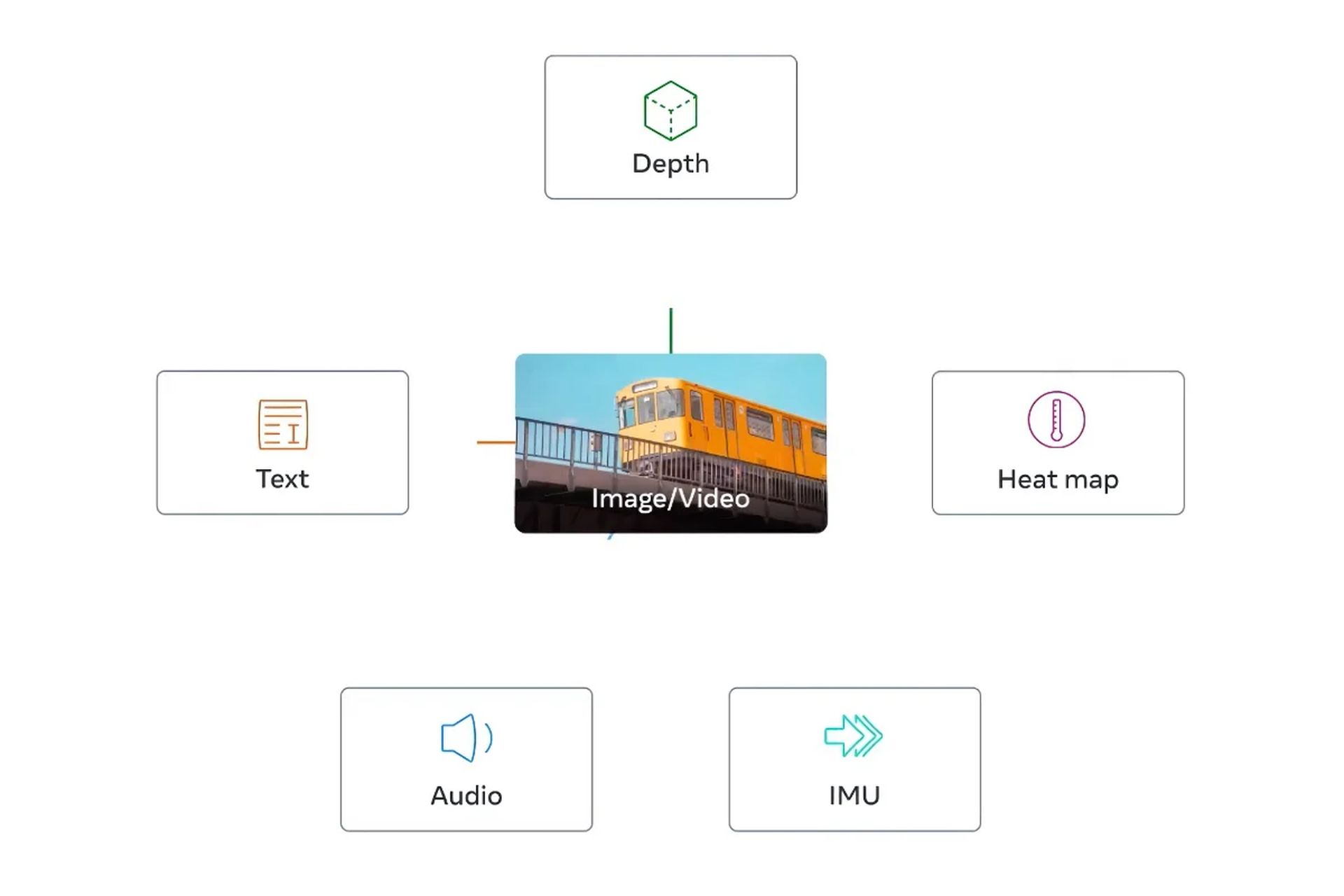

Secondo Meta ImageBind AI è il primo modello da integrare sei diversi forme di dati in un unico spazio di incorporamento. Visive (sotto forma di immagini e video), termiche (immagini a infrarossi), testo, audio, informazioni sulla profondità e, cosa più interessante, misurazioni del movimento prodotte da un’unità di misura inerziale, o IMU, sono le sei categorie di dati che sono incorporate nel modello.

Gli IMU vengono utilizzati nei telefoni e negli smartwatch per una varietà di funzioni, tra cui il passaggio di un telefono dalla modalità orizzontale a quella verticale e l’identificazione di varie forme di fisico attività.

L’idea è che, come fanno gli attuali sistemi di intelligenza artificiale con gli input di testo, i futuri sistemi di intelligenza artificiale saranno in grado di incrociare questi dati. Considera un futuristico sistema di realtà virtuale, ad esempio, che crea non solo input audio e visivi, ma anche il tuo ambiente E movimento su un vero palcoscenico

Se gli chiedevi di simulare una lunga crociera in mare, ti metteva su una nave con lo scuotimento del ponte sotto i piedi e il vento freddo dell’aria dell’oceano oltre al rumore delle onde in lontananza.

Come funziona Meta ImageBind AI?

In un post sul blog, Meta ImageBind AI menzioni che i modelli futuri potrebbero includere “tocco, parola, olfatto e segnali fMRI cerebrali”. La scoperta, secondo la dichiarazione, “porta le macchine un passo più vicino alla capacità degli esseri umani di apprendere simultaneamente, in modo olistico e direttamente da molte diverse forme di informazioni”. Che va bene; Qualunque cosa. la durata di queste fasi determinerà.)

Naturalmente tutto ciò è del tutto ipotetico, ed è probabile che gli utilizzi immediati di questo tipo di studi saranno notevolmente più limitati. Per esempio Meta mostrato l’anno scorso ha realizzato un modello di intelligenza artificiale che crea filmati brevi e sfocati dalle descrizioni testuali. Le future iterazioni del sistema potrebbero combinare flussi di dati aggiuntivi, producendo audio per integrare l’output video, ad esempio, come dimostrato da lavori come ImageBind.

Tuttavia, per coloro che seguono il settore, la ricerca è particolarmente intrigante poiché Meta ImageBind AI è l’open-sourcing del modello sottostante, una tendenza che viene osservata da vicino nel campo dell’IA.

Approccio open source Meta ImageBind AI: perché funziona?

Coloro che sono contrari all’open-sourcing, ad esempio OpenAIaffermano che l’approccio è dannoso per i creatori perché i concorrenti possono duplicare il loro lavoro e che potrebbe anche essere pericoloso poiché potrebbe consentire ad attori malvagi di sfruttare modelli di intelligenza artificiale all’avanguardia.

Rispondendo, i sostenitori affermano che l’open-sourcing consente a terze parti di esaminare i sistemi alla ricerca di difetti e correggere alcuni dei loro difetti. Sottolineano che potrebbe anche avere un vantaggio finanziario in quanto consente alle aziende di assumere programmatori esterni come dipendenti non retribuiti per migliorare il proprio lavoro.

Sebbene ci siano state sfide, Meta ImageBind AI è rimasta saldamente nel campo open source finora. (Ad esempio, il suo modello linguistico più recente, Lamaè stato rilasciato online all’inizio di quest’anno.) Per molti aspetti, la mancanza di successo commerciale dell’IA da parte dell’azienda (non ha un chatbot con cui competere Bing, BardoO ChatGPT) ha reso possibile questa strategia. Questa tattica è ancora utilizzata con ImageBind nel frattempo.

Dai un’occhiata agli articoli di seguito per rimanere aggiornato sui più recenti progressi tecnologici, in particolare quelli relativi all’intelligenza artificiale.

- Conoscere ChatGPT è la chiave per essere assunti: sì, dice una startup giapponese

- Visual ChatGPT è qui per evolvere i generatori di testo in immagine

- Midjourney V5 è qui per deliziare i tuoi occhi!

Source: Il modello Meta ImageBind AI apre nuovi orizzonti nell’IA generativa