Apple ha deciso di andare oltre nella sua lotta contro la pornografia infantile. L’azienda ha creato un nuovo sistema di scansione e crittografia con il quale terrà traccia delle foto dei suoi utenti alla ricerca di contenuti sospetti. La nuova funzione basata sul machine learning per il momento non arriverà in alcuni paesi, verrà testata prima negli Stati Uniti, ma ha già destato sospetti tra gli esperti di cybersecurity.

La società ha così confermato le informazioni avanzate su Twitter da Matthew Green, professore di crittografia alla Johns Hopkins University, giovedì. D’ora in poi, gli utenti iPhone riceveranno un avviso se una qualsiasi delle immagini che tentano di inviare tramite iMessage è sospettata di instillare abusi sessuali su minori.

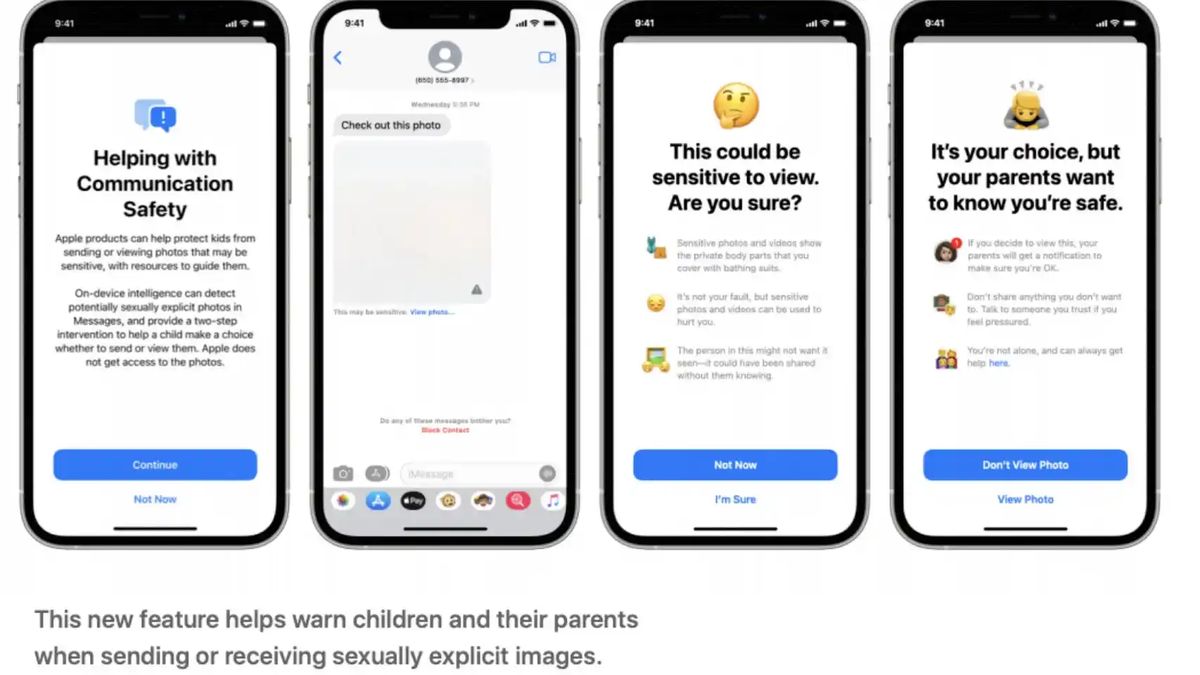

“Messages utilizza l’apprendimento automatico sul dispositivo per analizzare le immagini allegate e determinare se una foto è sessualmente esplicita. La funzione è progettata in modo che Apple non abbia accesso ai messaggi” dettagli Apple in un rapporto che illustra come funziona questo sistema, che non è così nuovo come sembra.

Come funziona?

La tecnologia verrà utilizzata in iOS, macOS, WatchOS e iMessage da cui verranno analizzate tutte le immagini che gli utenti intendono condividere. Per fare questo hanno fatto ricorso ad algoritmi di apprendimento automatico noti come NeuralHash.

La tecnologia hash analizza l’immagine senza la necessità di visualizzarla o aprire il file. Converte ogni fotografia in un numero univoco che ne descrive il contenuto, come un’impronta digitale, ma che sarebbe impossibile da capire per qualsiasi utente.

Dopo aver confrontato quel codice con quelli stabiliti dall’azienda come contenuti sospetti, se vengono rilevate sufficienti corrispondenze tra un codice e l’altro, viene creato un avviso che offusca l’immagine e ne impedisce la condivisione.

Apple assicura che i genitori saranno in grado di ricevere avvisi se i loro figli desiderano inviare contenuti classificati come sospetti. Le autorità potrebbero anche essere avvisate di queste partite in modo che una squadra umana possa rivedere le immagini.

Matteo Verde spiega sul suo account Twitter che questa tecnologia può dare falsi positivi in quanto non molto precisi: “Questo è fatto apposta. Sono progettati per trovare immagini che sembrano brutte immagini, anche se sono state ridimensionate, compresse, ecc.” L’azienda smentisce questa affermazione: “Il rischio che il sistema segnali erroneamente un account è estremamente basso. Inoltre, Apple esamina manualmente tutti i rapporti inviati a NCMEC per garantire l’accuratezza dei rapporti”.

I rischi per la privacy

Quello che potrebbe essere uno strumento chiave per perseguire criminali, pedofili e terroristi, rappresenta allo stesso tempo una minaccia per la privacy di cittadini innocenti e un’arma molto utile per i regimi totalitari, denuncia l’esperto di cybersecurity.

Il problema con questo nuovo strumento sarebbe piuttosto dove cercheranno quelle somiglianze. Le foto archiviate sui dispositivi e archiviate in iCloud vengono archiviate crittografate sui server Apple, ma come spiegano gli esperti, le chiavi per decrittografare questi codici sono di proprietà di Apple.

Gli unici che hanno la crittografia end-to-end (E2E) sono quelli di iMessage che, come WhatsApp, sono protetti da un dispositivo all’altro in modo che nessuno tranne gli utenti possa vederli. È qui che, in teoria, entrerebbe in gioco il nuovo sistema di Apple.

Questa analisi del contenuto non è così nuova. Facebook scansiona i post alla ricerca di nudità sui suoi social network (Facebook e Instagram). Apple ha anche utilizzato sistemi di hashing per cercare immagini di abusi sui minori inviate via e-mail, sistemi simili a Gmail e altri provider di posta elettronica cloud, che non sono protetti dalla crittografia end-to-end.

Green crede che questa tecnologia invii un messaggio preoccupante. “Indipendentemente dai piani a lungo termine di Apple, hanno inviato un segnale molto chiaro. (…) è sicuro costruire sistemi che scansionano i telefoni degli utenti alla ricerca di contenuti proibiti”, spiega sul suo profilo Twitter.

Tuttavia, non tutti gli esperti di sicurezza informatica sono stati così critici. Nicholas Weaver, ricercatore senior presso l’International Computer Science Institute dell’UC Berkeley, ha assicurato Scheda madre che la nuova funzione Messaggi di Apple “sembra una MOLTO buona idea”. “Nel complesso, l’approccio di Apple sembra ben pensato per essere efficace e massimizzare la privacy”, aggiunge.