Maia 100 di Microsoft è un acceleratore di intelligenza artificiale personalizzato, progettato per rivoluzionare il modo in cui i carichi di lavoro di intelligenza artificiale vengono eseguiti nel cloud.

Poiché la domanda di applicazioni basate sull’intelligenza artificiale continua a crescere, c’è una crescente necessità di hardware in grado di gestire le enormi richieste di elaborazione di questi carichi di lavoro. Maia è stato progettato specificamente per soddisfare questa esigenza, offrendo prestazioni, efficienza e scalabilità eccezionali.

Cos’è il chip Microsoft Maia 100?

Maia 100 è un chip acceleratore AI personalizzato sviluppato da Microsoft. È progettato per accelerare l’esecuzione di carichi di lavoro AI nel cloud. Maia 100 si basa su una nuova architettura specificamente ottimizzata per carichi di lavoro AI.

Questa architettura comprende un’unità tensoriale ad alta velocità, un processore vettoriale e un motore DMA.

Cosa rende Maia 100 speciale?

Maia 100 è un acceleratore di intelligenza artificiale altamente specializzato che offre diversi vantaggi chiave:

Alte prestazioni

Maia 100 è progettato per eccellere nella gestione di un’ampia gamma di carichi di lavoro AI, dall’elaborazione del linguaggio naturale alla visione artificiale e altro ancora. Le sue prestazioni eccezionali sono attribuite a:

- Elevata potenza termica di progettazione (TDP): Maia 100 può gestire fino a 700 W di potenza, consentendo di eseguire attività di intelligenza artificiale complesse senza surriscaldarsi o subire rallentamenti.

- Ampia larghezza di banda: Il chip offre un totale di 1,8 terabyte al secondo di larghezza di banda, assicurando che i dati possano fluire in modo fluido ed efficiente tra il processore e la memoria. Ciò è fondamentale per i carichi di lavoro AI che spesso coinvolgono grandi set di dati.

Efficienza

Maia 100 è progettato per essere efficiente dal punto di vista energetico, un fattore critico per ridurre i costi operativi e l’impatto ambientale. Questa efficienza è ottenuta tramite:

- Tipo di dati di archiviazione a bassa precisione: Utilizzando un tipo di dati a precisione inferiore, Maia 100 può ridurre la quantità di memoria richiesta per i calcoli, con conseguente miglioramento dell’efficienza energetica.

- Motore di compressione dati: Il chip incorpora un motore di compressione dati in grado di ridurre le dimensioni dei dati, migliorando ulteriormente l’efficienza e riducendo i requisiti di larghezza di banda.

Scalabilità

Maia 100 è progettato per scalare per soddisfare le crescenti richieste dei carichi di lavoro AI. Questa scalabilità è abilitata da:

- Interconnessioni basate su Ethernet: Maia 100 supporta interconnessioni basate su Ethernet ad alta larghezza di banda, consentendone una facile integrazione in cluster AI su larga scala. Ciò consente una comunicazione e un trasferimento dati senza interruzioni tra più chip Maia 100.

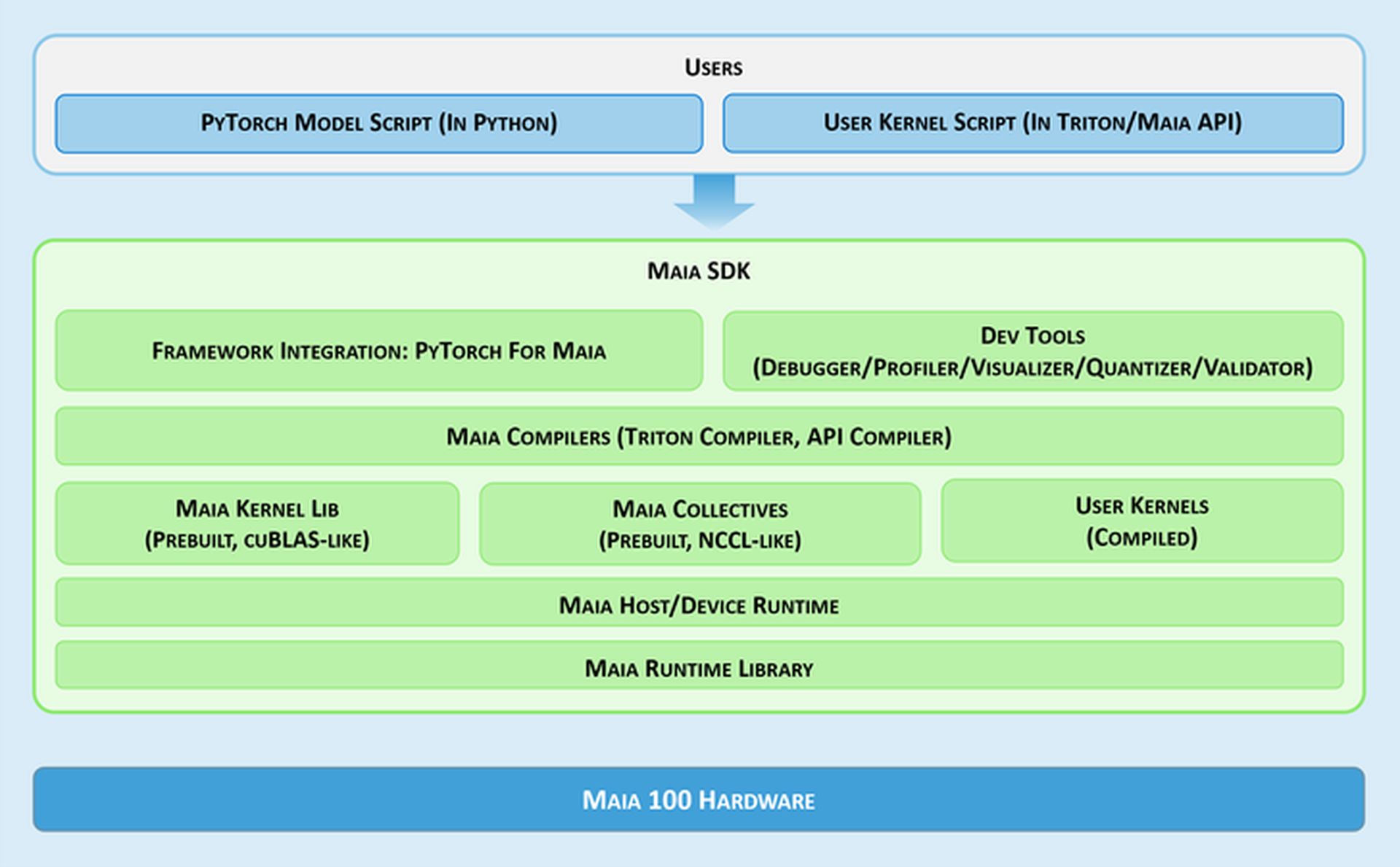

Strumenti per sviluppatori

Per facilitare lo sviluppo e l’implementazione di applicazioni AI su Maia, Microsoft fornisce un kit di sviluppo software (SDK) completo. Questo SDK include una gamma di strumenti che possono aiutare gli sviluppatori a:

- Debug: Identificare e correggere gli errori nei modelli di intelligenza artificiale.

- Profilo: Analizzare le prestazioni dei modelli di intelligenza artificiale per identificare i colli di bottiglia e ottimizzare il codice.

- Visualizzare: Visualizzare il comportamento dei loro modelli di intelligenza artificiale per ottenere informazioni sulle loro prestazioni.

- Quantizzare e convalidare: Convertire i modelli di intelligenza artificiale in formati a precisione inferiore per migliorare l’efficienza e convalidarne l’accuratezza.

Questi strumenti consentono agli sviluppatori di sfruttare in modo efficace le capacità di Maia 100 e di creare applicazioni di intelligenza artificiale ad alte prestazioni.

Il mercato è caldo!

Il mercato dell’hardware AI è altamente competitivo, con diversi attori principali che competono per la quota di mercato. Ecco alcuni dei principali concorrenti di Maia 100:

- NVIDIA: NVIDIA è un fornitore leader di hardware per l’intelligenza artificiale e le sue GPU delle serie Tesla e RTX sono ampiamente utilizzate per i carichi di lavoro di intelligenza artificiale.

- Informazioni: Intel offre una gamma di acceleratori di intelligenza artificiale, tra cui i processori Habana Gaudi e Intel Xeon Scalable.

- Deterioramento del sistema: Un altro attore importante nel mercato dell’hardware per l’intelligenza artificiale è AMD, con le sue GPU Radeon Instinct e le CPU EPYC.

- TPU di Google: La Tensor Processing Unit (TPU) di Google è un acceleratore di intelligenza artificiale personalizzato, progettato per carichi di lavoro di apprendimento automatico.

- Grafico core: Graphcore è un’azienda britannica di semiconduttori specializzata in acceleratori di intelligenza artificiale progettati per reti neurali grafiche.

- Sistemi cerebrali: Cerebras Systems è un’azienda con sede negli Stati Uniti che offre CS-2, un sistema informatico di intelligenza artificiale su larga scala.

Questi sono solo alcuni dei principali concorrenti di Maia. Il mercato dell’hardware AI è in continua evoluzione e nuovi attori potrebbero emergere in futuro.

Il mercato dell’hardware AI sta crescendo rapidamente. Poiché sempre più aziende implementano applicazioni basate su AI, c’è una crescente domanda di acceleratori AI ad alte prestazioni.

Maia 100 è ben posizionata per soddisfare questa domanda. Con le sue funzionalità e capacità avanzate, Maia 100 ha il potenziale per diventare una piattaforma di accelerazione AI leader.

Credito per l’immagine in evidenza: Microsoft

Source: Microsoft presenta il chip personalizzato Maia 100