Microsoft ha srotolato un nuovo entusiasmante sviluppo nel campo dei modelli linguistici: l’LLM a 1 bit. Questo avanzamento, ispirato da progetti di ricerca come BitNet, segna un notevole cambiamento nel modo in cui i modelli linguistici vengono costruiti e ottimizzati. Al centro di questa innovazione c’è un metodo sorprendentemente efficiente per rappresentare i parametri del modello – o pesi –utilizzando solo 1,58 bit, rispetto al tradizionale virgola mobile a 16 bit (FP16) approccio prevalente nei modelli precedenti.

Il primo LLM a 1 bit nel suo genere

Soprannominato BitNet LLM b1.58questo approccio pionieristico limita i valori potenziali di ciascun peso a sole tre opzioni: -1, 0 o +1. Questa drastica riduzione del numero di bit richiesti per parametro è ciò che pone le basi per questa tecnologia innovativa. Sorprendentemente, nonostante il suo scarso consumo di bit, BitNet b1.58 riesce a farlo fornire parametri di prestazione paragonabili a quelli dei modelli tradizionali. Ciò include aree come perplessità e prestazioni dell’attività finale, il tutto utilizzando le stesse dimensioni e set di dati di addestramento.

Cosa sono i LLM a 1 bit?

La scena dell’IA generativa si evolve giorno dopo giornoe l’ultima svolta in questa arena dinamica è l’avvento dei modelli di apprendimento linguistico a 1 bit. Potrebbe sembrare sorprendente, ma questo sviluppo ha il potenziale per trasformare l’arena dell’intelligenza artificiale affrontando alcuni degli ostacoli più significativi affrontati oggi dai LLM:vale a dire, la loro dimensione gigantesca.

In genere, i pesi di un modello di Machine Learning, che si tratti di un LLM o di qualcosa di semplice come la regressione logistica, vengono archiviati utilizzando Punti mobili a 32 o 16 bit. Questo approccio standard è un’arma a doppio taglio; sebbene consenta un’elevata precisione nei calcoli del modello, determina anche le dimensioni immense di questi modelli.

Questa abbondanza è proprio il motivo per cui l’implementazione di campioni di peso massimo come GPT su sistemi locali o in ambienti di produzione diventa un incubo logistico. Il loro numero astronomico di pesi, reso necessario dalla precisione di questi punti fluttuanti, aumenta le loro dimensioni fino a proporzioni ingestibili.

In netto contrasto con i modelli tradizionali, Gli LLM a 1 bit utilizzano solo un singolo bit, 0 o 1, per rappresentare i parametri di peso. Questa modifica apparentemente minore ha importanti implicazioni: riduce drasticamente le dimensioni complessive dei modelli, potenzialmente con un ampio margine.

Una tale riduzione delle dimensioni apre la strada alla diffusione di LLM su dispositivi molto più piccolirendendo più avanzate le applicazioni IA accessibile e fattibile su una gamma più ampia di piattaforme.

Torna a BitNet LLM b1.58

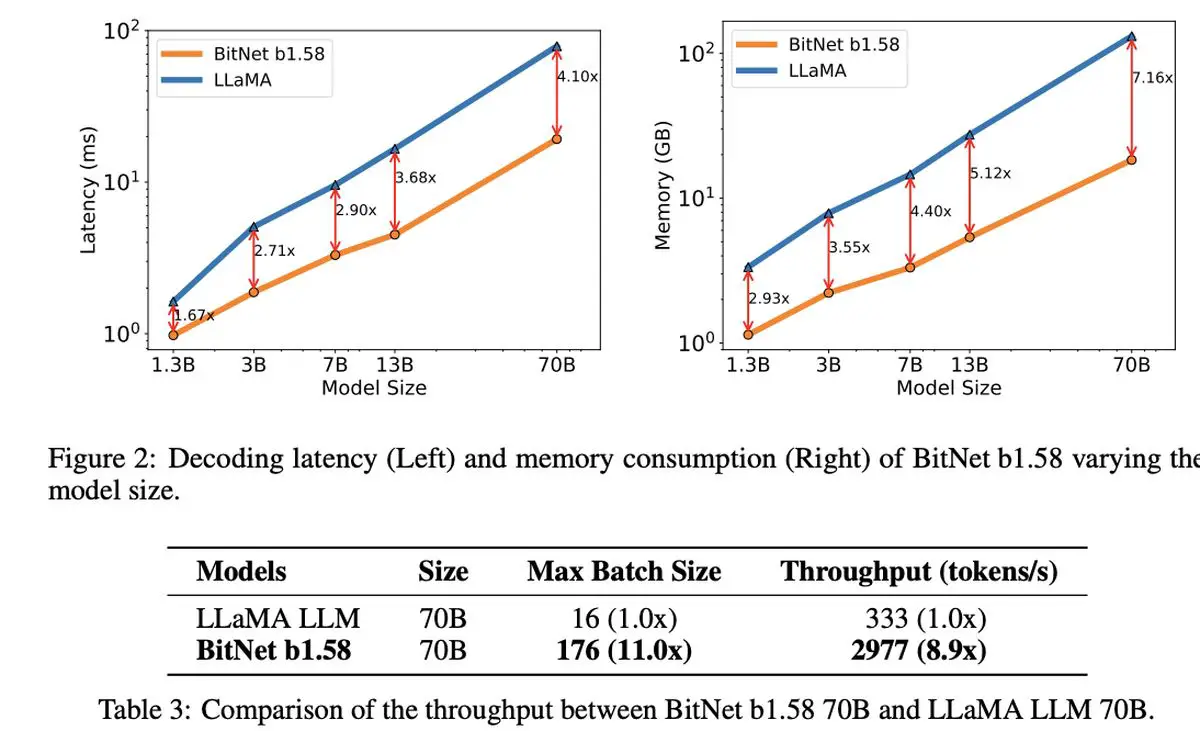

Ciò che è veramente notevole nel LLM a 1,58 bit è la sua efficacia dei costi. Il modello eccelle in termini di latenza ridotta, minor utilizzo della memoria, throughput migliorato e consumo energetico ridotto, presentando un’opzione sostenibile nel mondo computazionalmente intensivo dell’intelligenza artificiale.

Il LLM a 1 bit di Microsoft non si distingue solo per la sua efficienza. Rappresenta una nuova prospettiva sulla scalabilità e sulla formazione dei modelli linguistici, bilanciando prestazioni di alto livello con la sostenibilità economica. Allude all’alba di nuovi paradigmi informatici e alla possibilità di creare hardware specializzato su misura per eseguire questi modelli più snelli ed efficienti.

Si apre anche la discussione attorno a BitNet LLM b1.58 possibilità intriganti per gestire lunghe sequenze in modo più efficace nei LLMsuggerendo potenziali aree per ulteriori ricerche nelle tecniche di compressione senza perdite per aumentare ulteriormente l’efficienza.

All’ombra di questa notevole innovazione, anche Microsoft ha fatto parlare di sé con il suo ultimo modello Small Language, Phi-2. Questa centrale elettrica da 2,7 miliardi di parametri ha mostrato eccezionali capacità di comprensione e ragionamento, un’ulteriore prova dell’impegno costante di Microsoft nell’ampliare i confini della tecnologia AI. L’introduzione del LLM a 1 bit, insieme al successo di Phi-2, metterebbe in luce un’entusiasmante era di innovazione ed efficienza nello sviluppo di modelli linguistici.

Credito immagine in primo piano: Drew Beamer/Unsplash

Source: Microsoft presenta il suo LLM a 1 bit