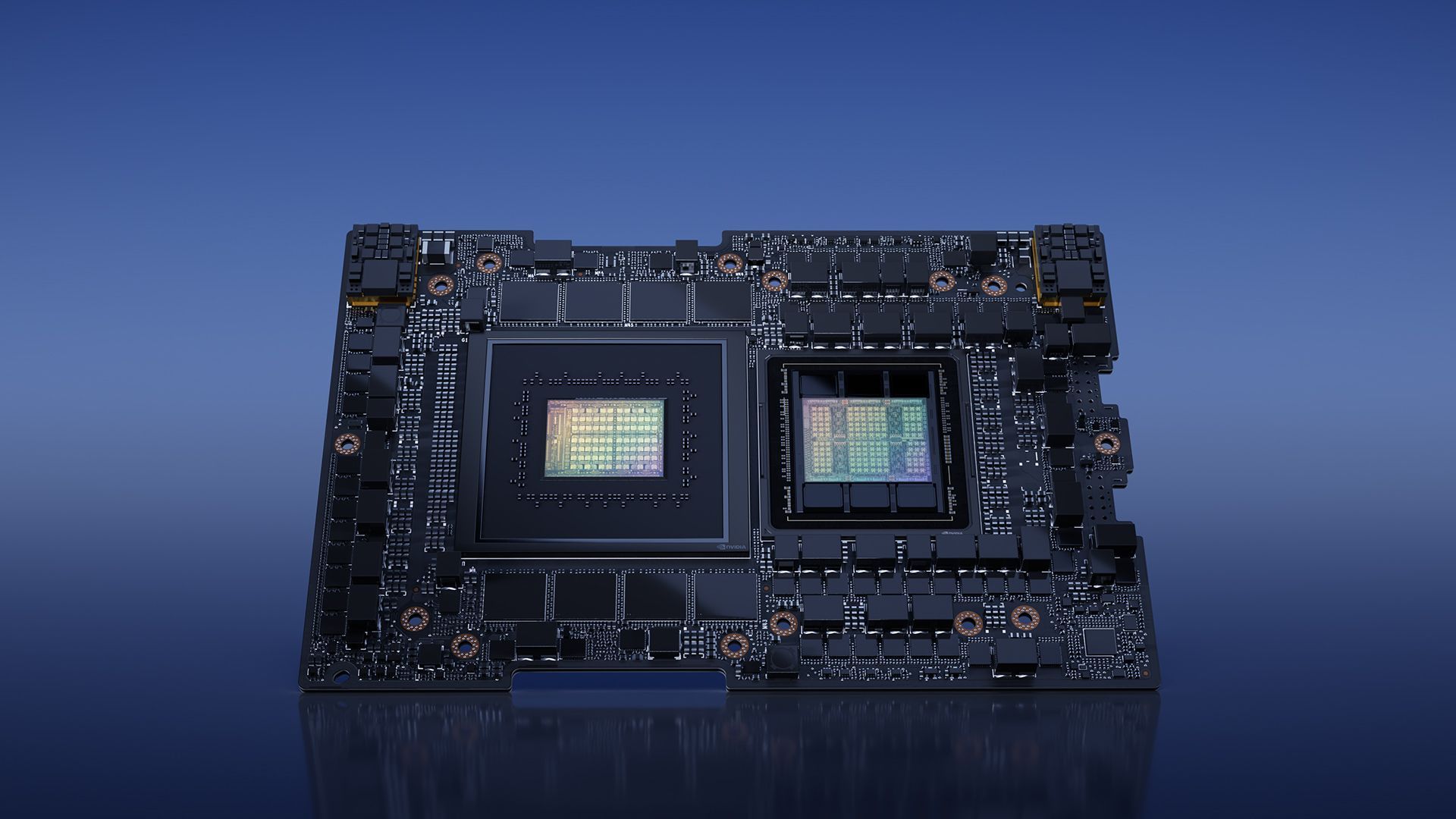

Nvidia sta rivoluzionando il mondo dell’intelligenza artificiale con il recente lancio di NVIDIA H200. Questa piattaforma all’avanguardia, costruita su la tramoggia NVIDIA architettura, vanta la potente GPU NVIDIA H200 Tensor Core, dotata di memoria avanzata progettato per affrontare carichi di dati sostanziali per carichi di lavoro di intelligenza artificiale generativa e calcolo ad alte prestazioni (HPC).

architettura, vanta la potente GPU NVIDIA H200 Tensor Core, dotata di memoria avanzata progettato per affrontare carichi di dati sostanziali per carichi di lavoro di intelligenza artificiale generativa e calcolo ad alte prestazioni (HPC).

In questo articolo approfondiremo il recente lancio e forniremo quanti più dettagli possibili sulla nuova NVIDIA H200.

La potenza di NVIDIA H200

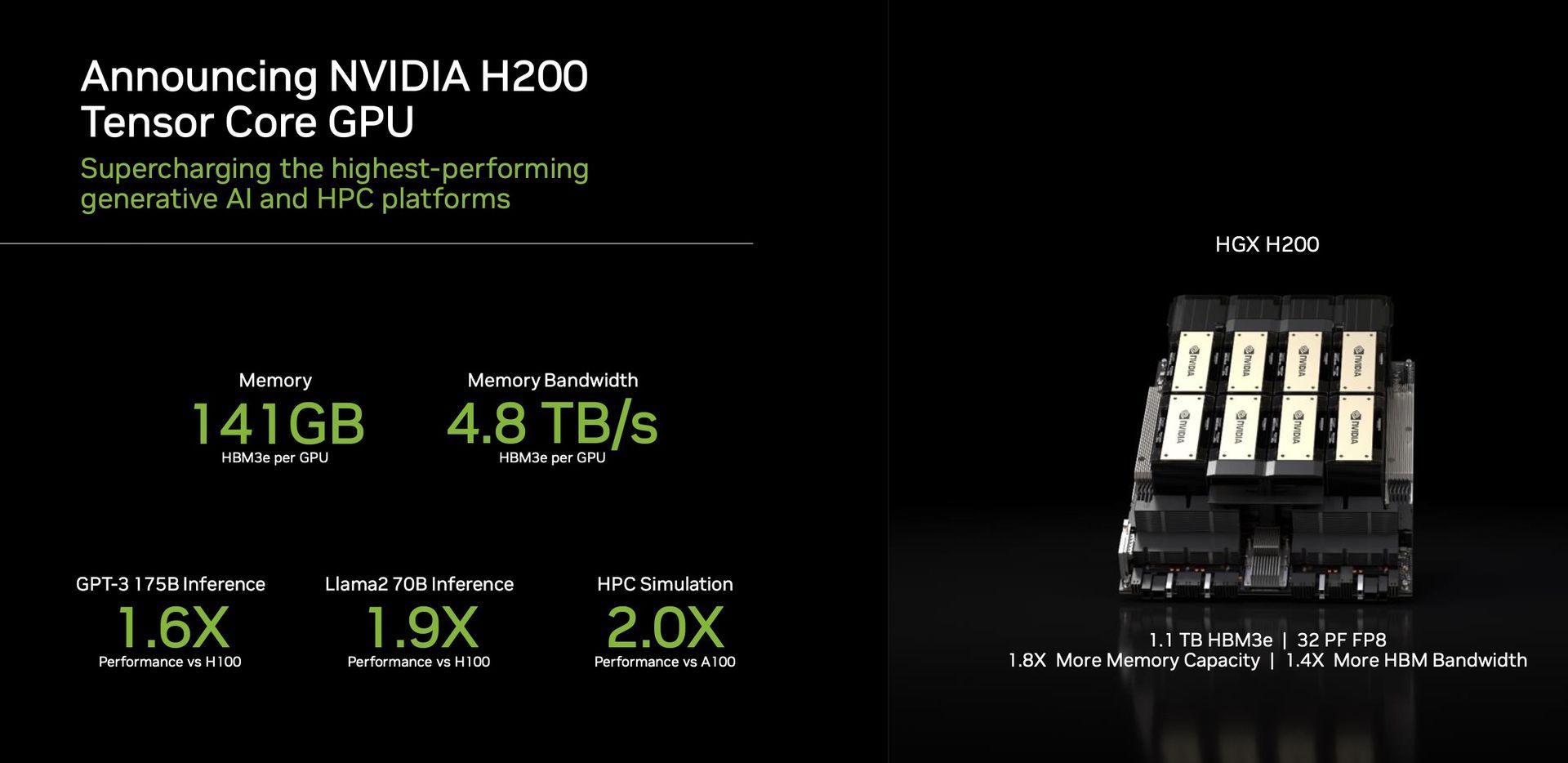

Una caratteristica distintiva dell’H200 è il suo utilizzo di HBM3e, la prima GPU a offrire questa memoria più veloce e più grande. Questo progresso spinge l’accelerazione dell’intelligenza artificiale generativa e dei modelli linguistici di grandi dimensioni, spingendo contemporaneamente i confini dell’intelligenza artificiale calcolo scientifico per carichi di lavoro HPC. Con HBM3e, l’H200 offre risultati impressionanti 141 GB di memoria ad un ritmo sconcertante 4,8 terabyte al secondo. Ciò rappresenta quasi il doppio della capacità e Larghezza di banda 2,4 volte maggiore rispetto al suo predecessore, la NVIDIA A100.

Prestazioni e applicazioni

L’H200, alimentato da NVIDIA NVLink e NVSwitch

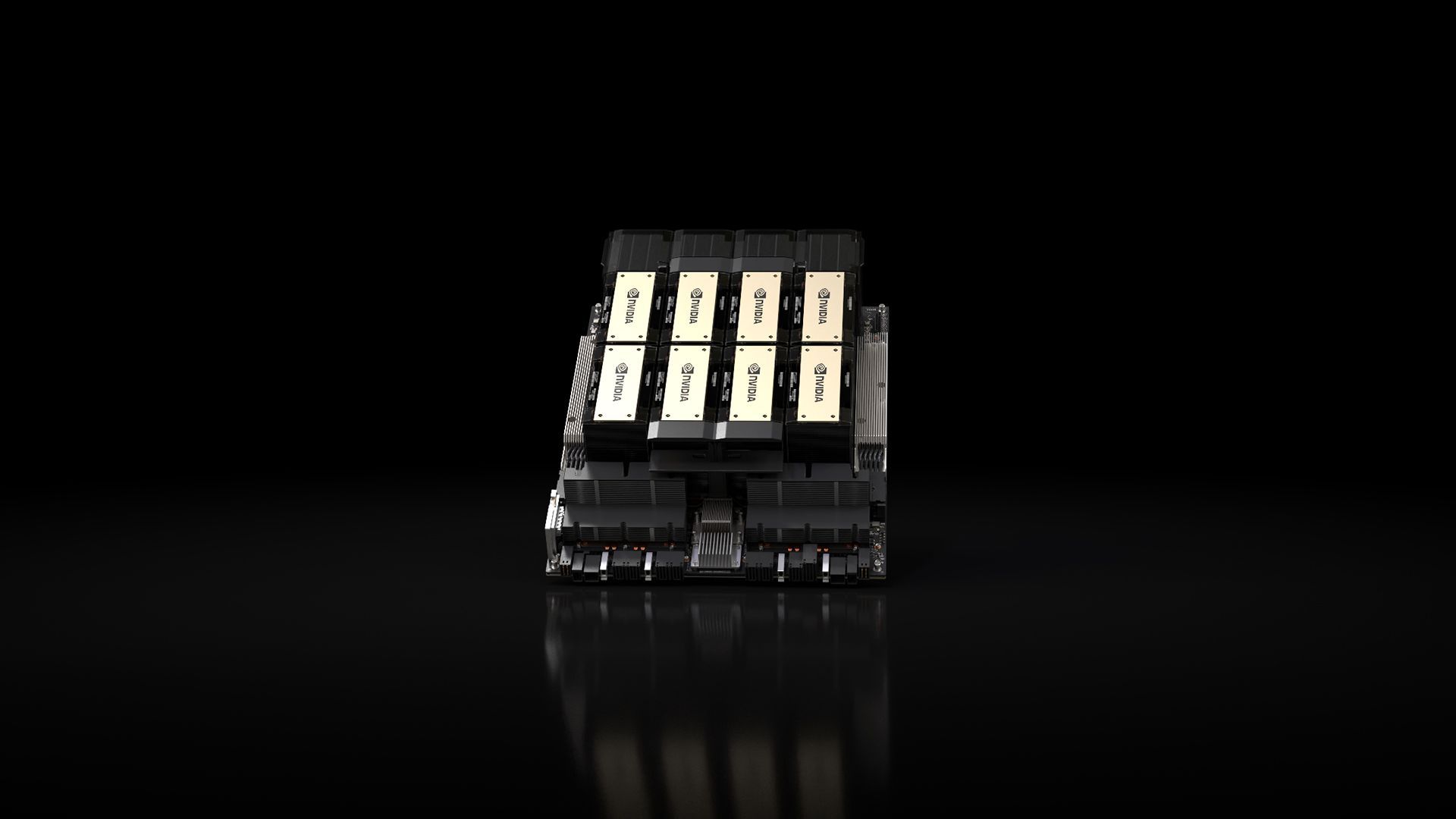

e NVSwitch interconnessioni ad alta velocità, promesse prestazioni senza pari tra vari carichi di lavoro applicativi. Ciò include la sua abilità nella formazione LLM (Large Language Model) e nell’inferenza per modelli che superano un colossale 175 miliardi di parametri. Un HGX H200 a otto vie si distingue per le sue prestazioni 32 petaflop di FP8 in profondità calcolo dell’apprendimento E una memoria aggregata ad alta larghezza di banda di 1,1 TB, garantendo le massime prestazioni nelle applicazioni AI e HPC generative.

interconnessioni ad alta velocità, promesse prestazioni senza pari tra vari carichi di lavoro applicativi. Ciò include la sua abilità nella formazione LLM (Large Language Model) e nell’inferenza per modelli che superano un colossale 175 miliardi di parametri. Un HGX H200 a otto vie si distingue per le sue prestazioni 32 petaflop di FP8 in profondità calcolo dell’apprendimento E una memoria aggregata ad alta larghezza di banda di 1,1 TB, garantendo le massime prestazioni nelle applicazioni AI e HPC generative.

Le GPU di Nvidia sono diventate fondamentale nel campo dei modelli di intelligenza artificiale generativa, svolgendo un ruolo cruciale nel loro sviluppo e implementazione. Progettate per gestire massicci calcoli paralleli necessari per l’addestramento e l’esecuzione di questi modelli, le GPU di Nvidia eccellono in attività come generazione di immagini E linguaggio naturale in lavorazione. L’architettura di elaborazione parallela consente a queste GPU di funzionare numerosi calcoli contemporaneamente, con conseguente sostanziale accelerazione dei processi del modello di intelligenza artificiale generativa.

L’H200 è una testimonianza dell’impegno di Nvidia nei confronti innovazione continua e miglioramenti prestazionali. Basandosi sul successo dell’architettura Hopper, i continui miglioramenti del software, incluso il recente rilascio di librerie open source come NVIDIA TensorRT -LLM, continuare ad elevare le prestazioni della piattaforma. L’introduzione di NVIDIA H200 promette ulteriori passi avanti, con aspettative di quasi raddoppiando la velocità di inferenza su modelli come Llama 2, un LLM da 70 miliardi di parametri, rispetto al suo predecessore, l’H100.

-LLM, continuare ad elevare le prestazioni della piattaforma. L’introduzione di NVIDIA H200 promette ulteriori passi avanti, con aspettative di quasi raddoppiando la velocità di inferenza su modelli come Llama 2, un LLM da 70 miliardi di parametri, rispetto al suo predecessore, l’H100.

Versatilità e disponibilità

Nvidia assicura versatilità con l’H200, offrendolo in vari fattori di forma come le schede server NVIDIA HGX H200 con configurazioni a quattro e otto vie. Queste configurazioni sono compatibili sia con l’hardware che con il software dei sistemi HGX H100. Inoltre, NVIDIA H200 è disponibile in la tramoggia Grace NVIDIA GH200 Superchip con HBM3e, adatto a diverse configurazioni di data center, inclusi ambienti on-premise, cloud, cloud ibrido ed edge. L’ecosistema globale dei produttori di server partner può farlo aggiornare senza problemi i loro sistemi esistenti con l’H200, garantendo un’accessibilità diffusa.

Superchip con HBM3e, adatto a diverse configurazioni di data center, inclusi ambienti on-premise, cloud, cloud ibrido ed edge. L’ecosistema globale dei produttori di server partner può farlo aggiornare senza problemi i loro sistemi esistenti con l’H200, garantendo un’accessibilità diffusa.

Gli appassionati e gli esperti del settore attendono con impazienza il rilascio dei sistemi HGX H200, che arriveranno sul mercato in il secondo trimestre del 2024. Importanti attori globali come Servizi Web di Amazon, Google Cloud, Microsoft Azure, E Infrastruttura Oracle Cloud sono tra la prima ondata di fornitori di servizi cloud pronto a distribuire istanze basate su H200 il prossimo anno.

architettura (Credito immagine)

architettura (Credito immagine)In conclusione, la NVIDIA H200, con le sue caratteristiche e capacità prestazionali rivoluzionarie, è destinata a ridefinire il panorama dell’informatica AI. Non appena sarà disponibile nel secondo trimestre del 2024, l’H200 è pronto a potenziare gli sviluppatori e le imprese di tutto il mondo, accelerare lo sviluppo e l’implementazione di applicazioni IA dal parlato all’inferenza su iperscala.

Nel frattempo, se sei interessato all’azienda leader nel settore tecnologico, assicurati di consultare anche il nostro articolo su come Nvidia e AMD stanno lavorando su un “chip basato su braccio”.

Credito immagine in primo piano: NVIDIA

Source: NVIDIA H200 viene introdotta con grande anticipo nel campo dell’intelligenza artificiale