OpenAI ha lanciato funzionalità video in tempo reale per ChatGPT, integrando funzionalità visive nella sua modalità vocale avanzata. Questo annuncio è stato fatto durante un evento in live streaming tenutosi il 12 dicembre 2024. La versione aggiornata può riconoscere oggetti in tempo reale attraverso la fotocamera del dispositivo dell’utente, elaborare informazioni visive tramite la condivisione dello schermo e impegnarsi in conversazioni simili a quelle umane. Disponibile per gli abbonati a ChatGPT Plus, Team e Pro, l’aggiornamento verrà implementato nel corso della prossima settimana, con alcuni utenti nell’UE che dovranno affrontare potenziali ritardi.

Con questo miglioramento, ChatGPT può rispondere agli utenti interpretando ciò che vede, ad esempio offrendo spiegazioni sulle impostazioni di un dispositivo o fornendo suggerimenti per risolvere problemi di matematica. Per utilizzare queste funzionalità, gli utenti possono toccare l’icona della voce nell’app ChatGPT e attivare la condivisione di video o schermo. L’implementazione ha la priorità per gli abbonati Plus, mentre gli utenti ChatGPT Enterprise ed Edu avranno accesso a gennaio 2025.

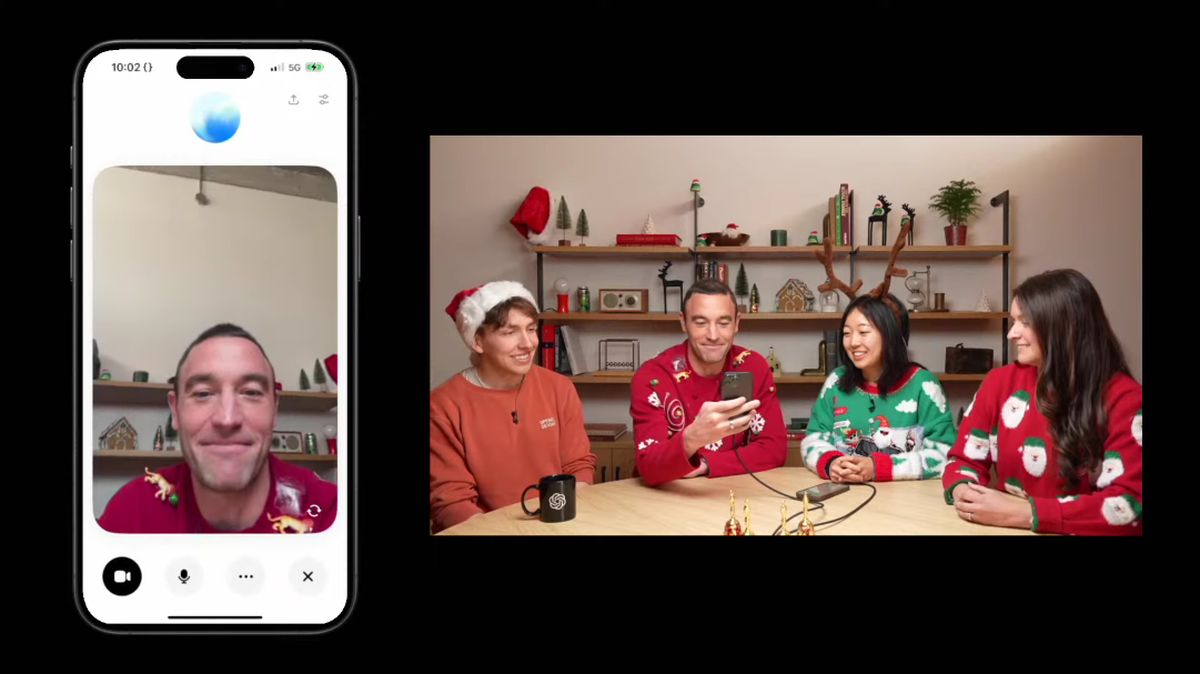

OpenAI mostra funzionalità avanzate nella dimostrazione dal vivo

Durante la recente dimostrazione dal vivo, il presidente di OpenAI Greg Brockman ha evidenziato le capacità coinvolgenti della modalità vocale avanzata con visione. Brockman ha interrogato Anderson Cooper della CNN sull’anatomia mentre dimostrava come ChatGPT potesse comprendere e commentare i disegni realizzati da Cooper su una lavagna. L’interazione ha illustrato il potenziale di apprendimento e feedback interattivi in tempo reale, sebbene ChatGPT abbia mostrato alcuni errori, come il calcolo errato di un problema di geometria, sottolineando le sfide in corso relative all’accuratezza del modello.

Questa funzionalità aggiornata ha dovuto affrontare ritardi nello sviluppo, con OpenAI che in precedenza suggeriva finestre di lancio che alla fine sono state estese. Presentata originariamente nel maggio 2024, ci si aspettava che la modalità vocale avanzata arrivasse prima. Il recente annuncio mostra il culmine degli sforzi volti a perfezionare e finalizzare questa capacità, indicando un focus strategico sul miglioramento dell’esperienza utente e delle capacità tecnologiche del chatbot.

Oltre alle nuove funzionalità visive, OpenAI ha anche svelato una “Modalità Babbo Natale” per le festività natalizie, consentendo agli utenti di interagire con ChatGPT in tono festoso. Per accedere a questa funzione, gli utenti possono fare clic sull’icona del fiocco di neve nell’applicazione. Questa opzione stagionale reimposta i limiti di utilizzo per l’interazione iniziale, offrendo agli utenti maggiori opportunità di interagire con la funzionalità festiva.

Rivali come Google e Meta stanno sviluppando funzionalità simili, come Project Astra di Google, che è stato recentemente reso disponibile a tester selezionati su Android. Questi sforzi riflettono una tendenza più ampia secondo cui le principali aziende tecnologiche stanno lavorando per integrare funzionalità video interattive nei loro modelli di intelligenza artificiale, migliorando il coinvolgimento degli utenti e la versatilità delle applicazioni.

OpenAI ha anche indicato piani per implementare altri miglioramenti, come il rafforzamento del suo programma di ricerca di messa a punto del rinforzo, progettato per ottimizzare le prestazioni del modello in compiti specializzati. Questo programma è rivolto a istituti di ricerca e imprese, consentendo loro di personalizzare i modelli OpenAI per applicazioni complesse.

Credito immagine in primo piano: OpenAI

Il post OpenAI lancia funzionalità video in tempo reale per ChatGPT è apparso per la prima volta su TechBriefly.

Source: OpenAI lancia funzionalità video in tempo reale per ChatGPT