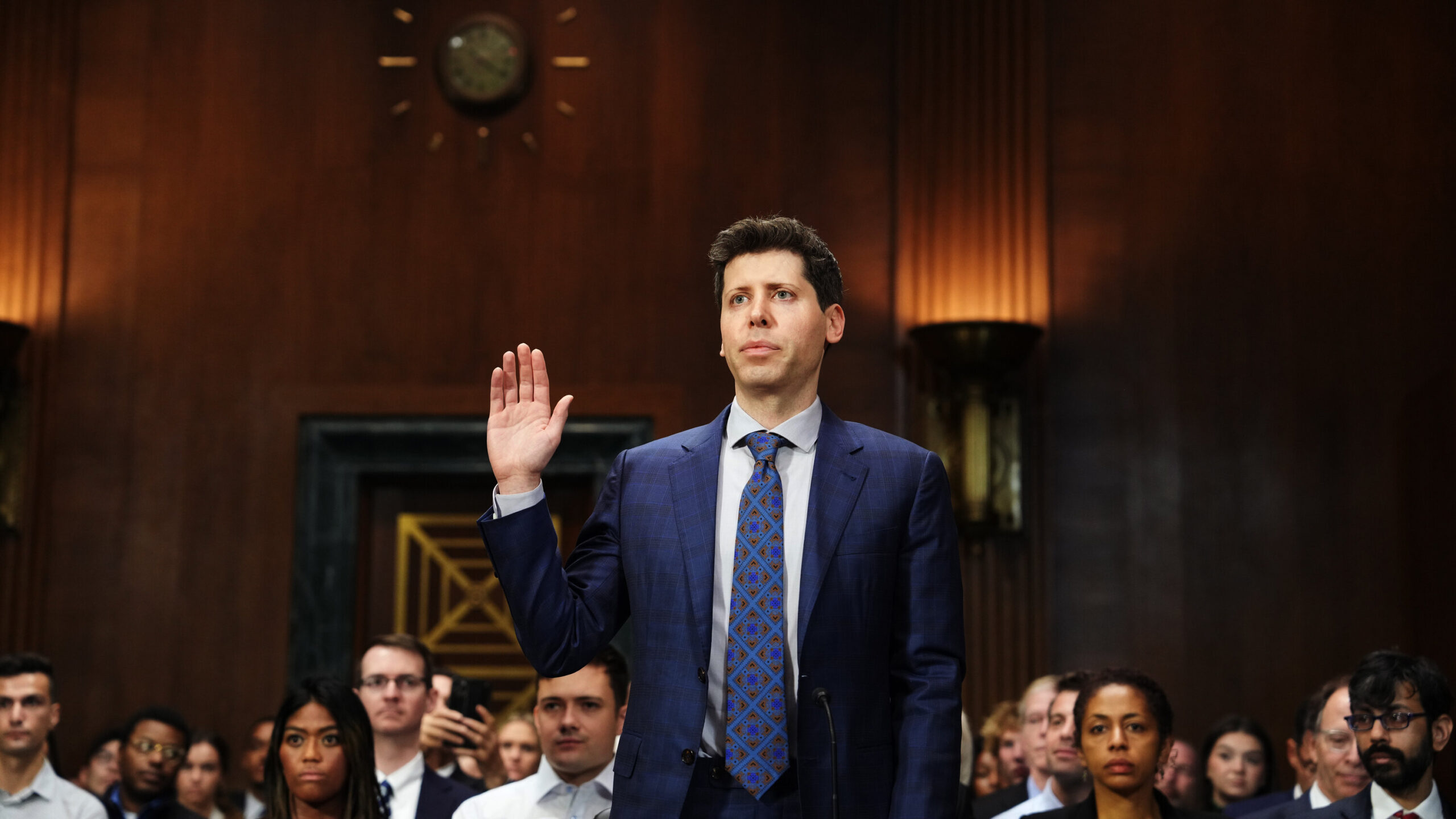

CEO di OpenAI Sam Altmann continua il suo raggio d’azione internazionale, basandosi sullo slancio generato dalle sue recenti apparizioni davanti al Congresso degli Stati Uniti. Tuttavia, l’approccio di Altman all’estero differisce dal clima favorevole all’IA negli Stati Uniti, poiché accenna alla possibilità di trasferire le sue iniziative tecnologiche se il rispetto delle sue regole non viene rispettato.

Il viaggio in giro per il mondo di Altman lo ha portato via Lagos, Nigeria verso varie destinazioni europee, culminando in Londra, Regno Unito. Nonostante abbia affrontato alcune proteste, si impegna attivamente con figure di spicco dell’industria tecnologica, delle imprese e dei responsabili politici, sottolineando le capacità del modello linguistico ChatGPT di OpenAI. Altman cerca di raccogliere sostegno per le normative pro-IA mentre esprime malcontento per la definizione dell’Unione Europea di sistemi “ad alto rischio”, come discusso durante un panel all’University College di Londra.

IL La proposta di legge sull’IA dell’Unione europea introduce una classificazione a tre livelli per i sistemi di IA basata sui livelli di rischio. I casi di intelligenza artificiale che presentano un “rischio inaccettabile” violando i diritti fondamentali includono i sistemi di punteggio sociale e l’intelligenza artificiale manipolativa dell’ingegneria sociale. D’altra parte, i “sistemi di intelligenza artificiale ad alto rischio” devono aderire a standard completi di trasparenza e supervisione, adattati all’uso previsto.

Sam Altman ha espresso preoccupazione per l’attuale progetto di legge, affermando che sia ChatGPT che l’imminente GPT-4 potrebbero potenzialmente rientrare nella categoria ad alto rischio. In tali casi sarebbe necessario il rispetto di requisiti specifici. Altman ha sottolineato l’intenzione di OpenAI di impegnarsi per la conformità, ma ha riconosciuto che esistono limitazioni tecniche che potrebbero influire sulla loro capacità di farlo. COME riportato dal Tempo, ha dichiarato: “Se possiamo obbedire, lo faremo, e se non possiamo, cesseremo di operare… Ci proveremo. Ma ci sono limiti tecnici a ciò che è possibile”.

La legge sull’IA dell’UE viene aggiornata man mano che l’IA continua a migliorare

Originariamente mirato ad affrontare le preoccupazioni relative al sistema di credito sociale cinese e al riconoscimento facciale, l’AI Act ha incontrato nuove sfide con l’emergere di OpenAI e di altre startup. L’UE ha successivamente introdotto disposizioni a dicembre, prendendo di mira i “modelli fondamentali” come i modelli linguistici di grandi dimensioni (LLM) che alimentano i chatbot di intelligenza artificiale come ChatGPT. Di recente, una commissione del Parlamento europeo ha approvato questi regolamenti aggiornati, applicando i controlli di sicurezza e la gestione dei rischi.

A differenza degli Stati Uniti, l’UE ha mostrato una maggiore propensione a esaminare OpenAI. IL Comitato europeo per la protezione dei dati ha monitorato attivamente la conformità di ChatGPT alle leggi sulla privacy. Tuttavia, è importante notare che l’AI Act è ancora soggetto a potenziali revisioni, il che probabilmente spiega il tour globale di Altman, cercando di navigare nel panorama in evoluzione delle normative sull’IA.

Altman ha ribadito punti familiari della sua recente testimonianza al Congresso, esprimendo sia preoccupazioni sui rischi dell’IA sia riconoscendo i suoi potenziali benefici. Ha sostenuto la regolamentazione, compresi i requisiti di sicurezza e un’agenzia governativa per i test di conformità. Altman ha chiesto un approccio normativo che trovi un equilibrio tra le tradizioni europee e americane.

Tuttavia, Altman ha messo in guardia contro le normative che potrebbero limitare l’accesso degli utenti, danneggiare le aziende più piccole o impedire il movimento dell’IA open source. La posizione in evoluzione di OpenAI sull’apertura, citando la concorrenza, contrasta con le sue pratiche precedenti. Vale la pena notare che qualsiasi nuova regolamentazione andrebbe intrinsecamente a vantaggio di OpenAI fornendo un quadro per la responsabilità. I controlli di conformità potrebbero anche aumentare il costo dello sviluppo di nuovi modelli di intelligenza artificiale, offrendo all’azienda un vantaggio nel panorama competitivo dell’IA.

Diversi paesi hanno imposto divieti su ChatGPT, e l’Italia è uno di questi. Tuttavia, dopo che OpenAI ha migliorato i controlli sulla privacy degli utenti, il divieto è stato revocato dal governo di estrema destra italiano. OpenAI potrebbe dover continuare ad affrontare le preoccupazioni e fare concessioni per mantenere una relazione favorevole con i governi di tutto il mondo, soprattutto considerando la sua ampia base di utenti di oltre 100 milioni di utenti ChatGPT attivi.

Perché i governi agiscono con cautela sui chatbot AI?

Ci sono una serie di motivi per cui i governi possono imporre divieti su ChatGPT o modelli di intelligenza artificiale simili per diversi motivi:

- Disinformazione e Fake News: I modelli di intelligenza artificiale come ChatGPT possono generare informazioni fuorvianti o false, contribuendo alla diffusione della disinformazione. I governi possono imporre divieti per impedire la diffusione di contenuti imprecisi o dannosi.

- Contenuto inappropriato o offensivo: I modelli di intelligenza artificiale hanno il potenziale per generare contenuti inappropriati, offensivi o che violano norme e valori culturali. I governi possono vietare ChatGPT per proteggere i cittadini dall’incontro con materiale discutibile.

- Preoccupazioni etiche: I modelli di intelligenza artificiale sollevano questioni etiche relative alla privacy, al consenso e ai pregiudizi. I governi possono imporre divieti per affrontare le preoccupazioni sulla privacy dei dati, il potenziale uso improprio delle informazioni personali o la perpetuazione di pregiudizi nei contenuti generati dall’intelligenza artificiale.

- Conformità normativa: i modelli di intelligenza artificiale devono rispettare le leggi e i regolamenti esistenti. I governi possono imporre divieti se scoprono che ChatGPT non soddisfa i requisiti normativi, come la protezione dei dati o gli standard sui contenuti.

- Sicurezza nazionale e stabilità sociale: i governi possono percepire i modelli di intelligenza artificiale come una potenziale minaccia alla sicurezza nazionale o alla stabilità sociale. Possono imporre divieti per prevenire l’uso improprio della tecnologia AI per scopi dannosi o per mantenere il controllo sul flusso di informazioni.

Vale la pena notare che i motivi specifici per i divieti imposti dal governo su ChatGPT possono variare a seconda delle giurisdizioni e le decisioni sono influenzate da una combinazione di fattori legali, etici, sociali e politici. Per alcuni rischi attuali e conseguenze indesiderate dei chatbot AI, controlla questi ultimi articoli:

- Rischi ChatGPT esposti: comprensione delle potenziali minacce

- Il lato oscuro di ChatGPT: il costo umano del successo dell’IA

Source: Sam Altman di OpenAI minaccia l’uscita dall’UE durante i colloqui sulla regolamentazione dell’IA