Il trailer di Megalopolis è nei guai dopo che è stato rivelato che alcune delle sue citazioni di recensione erano false e generate dall’intelligenza artificiale. Eddie Egan, responsabile del marketing del trailer, è stato rimosso dal suo incarico a causa di questo pasticcio.

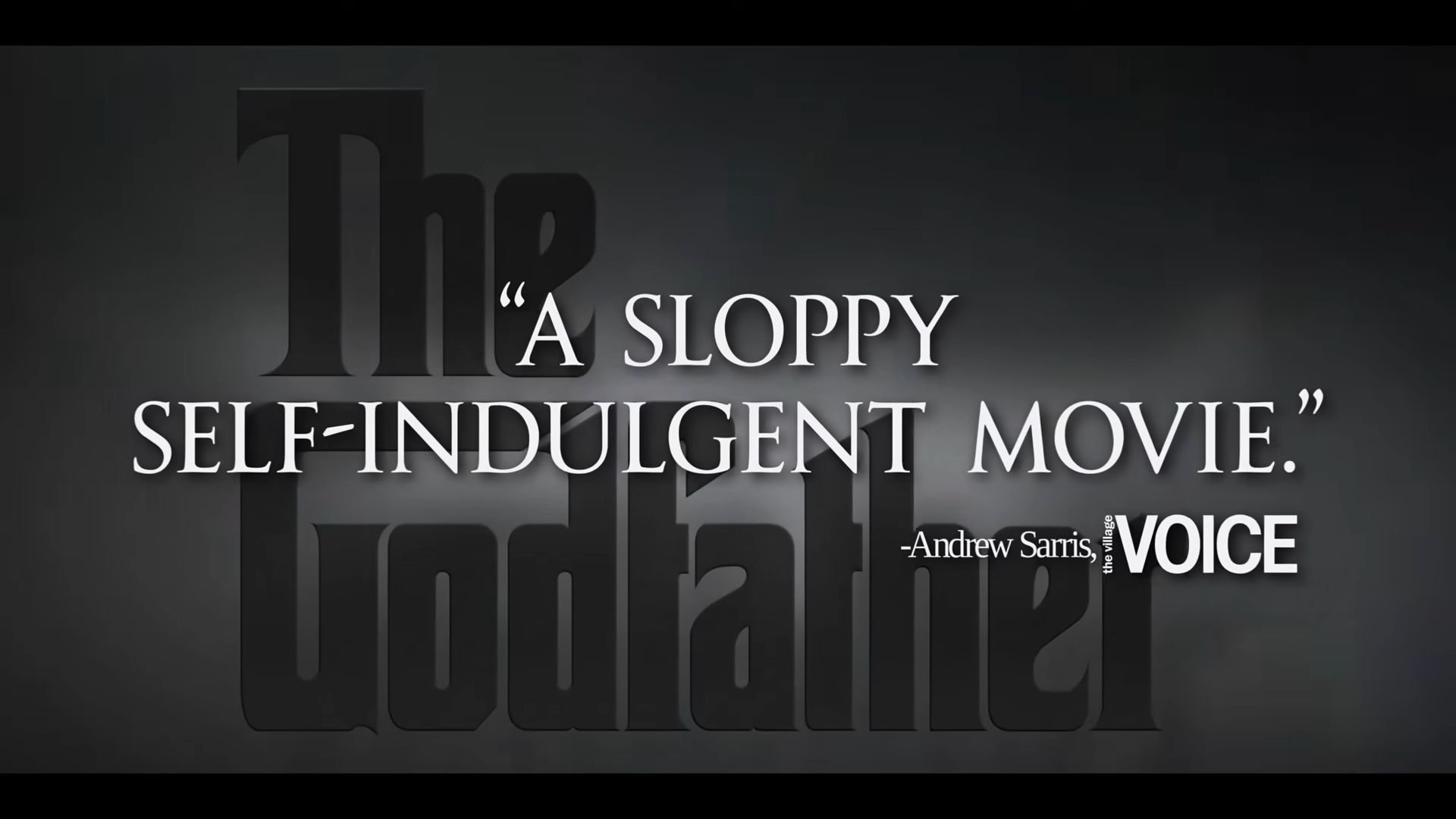

Il trailer includeva recensioni inventate che criticavano i film classici di Francis Ford Coppola. Affermava falsamente che “Il Padrino” era un “film sciatto e autoindulgente” e che “Apocalypse Now” era “un epico pezzo di spazzatura”. In realtà, le recensioni originali erano positive e lodavano i film.

Questa situazione evidenzia un problema crescente con l’IA: può avere allucinazioni. Questo non è solo un problema per i trailer dei film; gli errori dell’IA hanno influenzato anche documenti legali e casi giudiziari. Ad esempio, l’avvocato di Michael Cohen ha presentato casi giudiziari falsi e gli avvocati di una compagnia aerea colombiana hanno commesso errori simili. Persino il rapper Pras Michél ha perso una causa legale perché il suo avvocato ha utilizzato un argomento generato dall’IA.

Cosa sono le allucinazioni dell’intelligenza artificiale? Lo scandalo del trailer di Megalopolis mostra come funzionano

Le allucinazioni AI si verificano quando l’intelligenza artificiale genera informazioni che sembrano convincenti ma in realtà sono false o fuorvianti. Lo scandalo del trailer di “Megalopolis” ha portato questo termine alla ribalta.

In questo caso, il trailer presentava false citazioni di recensioni sui film di Francis Ford Coppola, sostenendo che “Il Padrino” era “sciatto” e “Apocalypse Now” era “un epico pezzo di spazzatura”. L’IA ha creato queste citazioni, ma non corrispondevano alle reali recensioni positive di questi film. L’IA ha “allucinato” queste citazioni, producendo affermazioni credibili ma false.

Le allucinazioni dell’IA accadono perché la tecnologia può generare testo in base a schemi appresi dai dati, ma non ne comprende veramente il contenuto. Può confondere i fatti, creare errori o inventare tutto, che è ciò che è successo con le recensioni fuorvianti nel trailer.

Questo incidente evidenzia i rischi di affidarsi all’IA senza controlli adeguati. Proprio come nel caso “Megalopolis”, in cui citazioni false hanno portato a gravi conseguenze per i soggetti coinvolti, le allucinazioni dell’IA possono causare confusione e danni se non gestite con attenzione. È un promemoria del fatto che, sebbene l’IA possa essere potente, è fondamentale verificarne l’output per evitare informazioni fuorvianti.

Credito immagine in evidenza: Italiano:

Source: Se usi l’intelligenza artificiale in questo modo perderai il lavoro