Il Meta Llama 3.1 405B è stato annunciato ufficialmente, facendosi un nome prima ancora che le sue capacità AI fossero lanciate. Sviluppato da Meta, questo modello all’avanguardia offre flessibilità, controllo e prestazioni senza precedenti per rivaleggiare con i migliori modelli AI closed-source.

Ieri, alcuni utenti hanno avuto un assaggio anticipato del suo potenziale e oggi abbiamo test di benchmark ufficiali che evidenziano le sue impressionanti capacità. Puoi anche leggere di più sulle rivelazioni di ieri qui.

Che cos’è Meta Llama 3.1 405B?

Oggi qui impareremo tutto quello che c’è da sapere su Meta Llama 3.1 405B. Llama 3.1 405B è un’IA open source che eccelle in una varietà di attività come conoscenza generale, navigabilità, matematica, utilizzo di strumenti e traduzione multilingue, mentre le versioni di livello intermedio 70B e di livello minimo 8B eccellono anche nelle rispettive classi. Con una lunghezza di contesto di 128K e il supporto per otto lingue, questo modello è progettato per gestire applicazioni complesse e diversificate.

Addestrato su oltre 15 trilioni di token utilizzando oltre 16 mila GPU H100, Llama 3.1 405B si distingue come uno dei modelli di IA più potenti e capaci disponibili. Molta energia è stata investita in questa IA. Ora possiamo iniziare a entrare nel dettaglio.

Caratteristiche principali di Meta Llama 3.1 405B

Meta lama 3.1 405B offre diverse funzionalità avanzate:

- Lunghezza del contesto estesa: Supporta una lunghezza di contesto fino a 128K, ideale per riepiloghi di testo lunghi e conversazioni complesse.

- Capacità multilingue: Gestisce più lingue, rendendolo versatile per applicazioni globali.

- Utilizzo avanzato degli strumenti: Capace di integrarsi con vari strumenti per funzionalità avanzate.

- Generazione di dati sintetici: Facilita la creazione di dati sintetici per migliorare e addestrare modelli più piccoli.

- Distillazione del modello: Consente di distillare modelli di grandi dimensioni in versioni più piccole e più efficienti.

Meta ha collaborato con più di 25 aziende per realizzare Meta lama 3.1 405B più facile da usare. Questo supporto dell’ecosistema rende più fattibile per sviluppatori e ricercatori lavorare con questo potente modello, anche senza accesso a enormi risorse computazionali.

Come utilizzare Meta Llama 3.1 405B

Per iniziare a utilizzare Meta Llama 3.1 405B, segui questi passaggi:

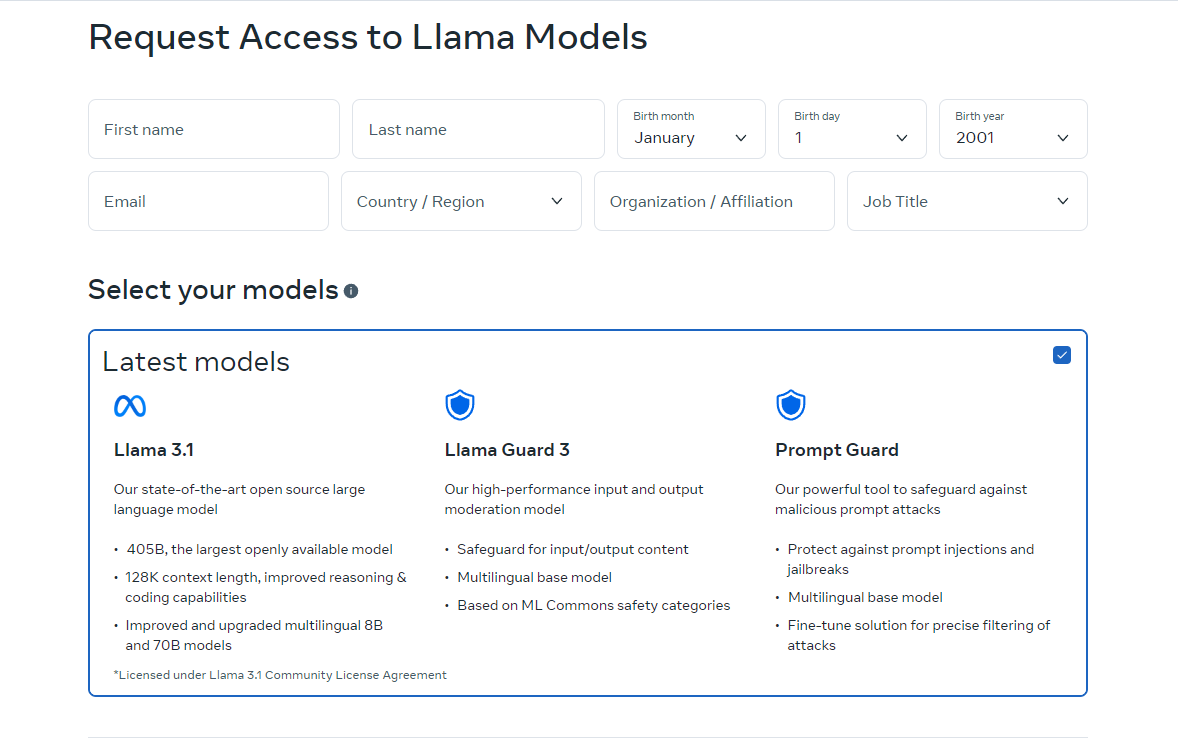

- Accedi al modello: Visita lama.meta.com O Faccia abbracciata A scaricamento il modello. Queste piattaforme forniscono i file e la documentazione necessari per iniziare.

- Imposta il tuo ambiente: Assicurati di avere un ambiente adatto per l’esecuzione del modello. Ciò include avere l’hardware richiesto, come le GPU, e dipendenze software come Python e PyTorch.

- Carica il modello: Utilizza i frammenti di codice e le linee guida forniti per caricare il modello nella tua applicazione. Meta fornisce istruzioni dettagliate per aiutarti a integrare Llama 3.1 405B nei tuoi progetti.

- Eseguire l’inferenza: Inizia a usare il modello per inferenza in tempo reale o in batch. Puoi porre domande al modello, generare testo o eseguire traduzioni usando le sue potenti capacità.

- Ottimizzazione per attività specifiche: Se necessario, puoi perfezionare il modello per applicazioni specifiche utilizzando tecniche di perfezionamento supervisionato. Meta offre risorse ed esempi per guidarti in questo processo.

La versione online di Llama è attualmente disponibile solo in alcuni paesi. Tuttavia, puoi anche utilizzarla localmente scaricando i codici open source. Le istruzioni per il download sono disponibili sui siti a cui ti indirizziamo. Puoi anche utilizzare Meta Llama 3.1 405B tramite Grog.

Come usare Meta Llama 3.1 405B su Groq

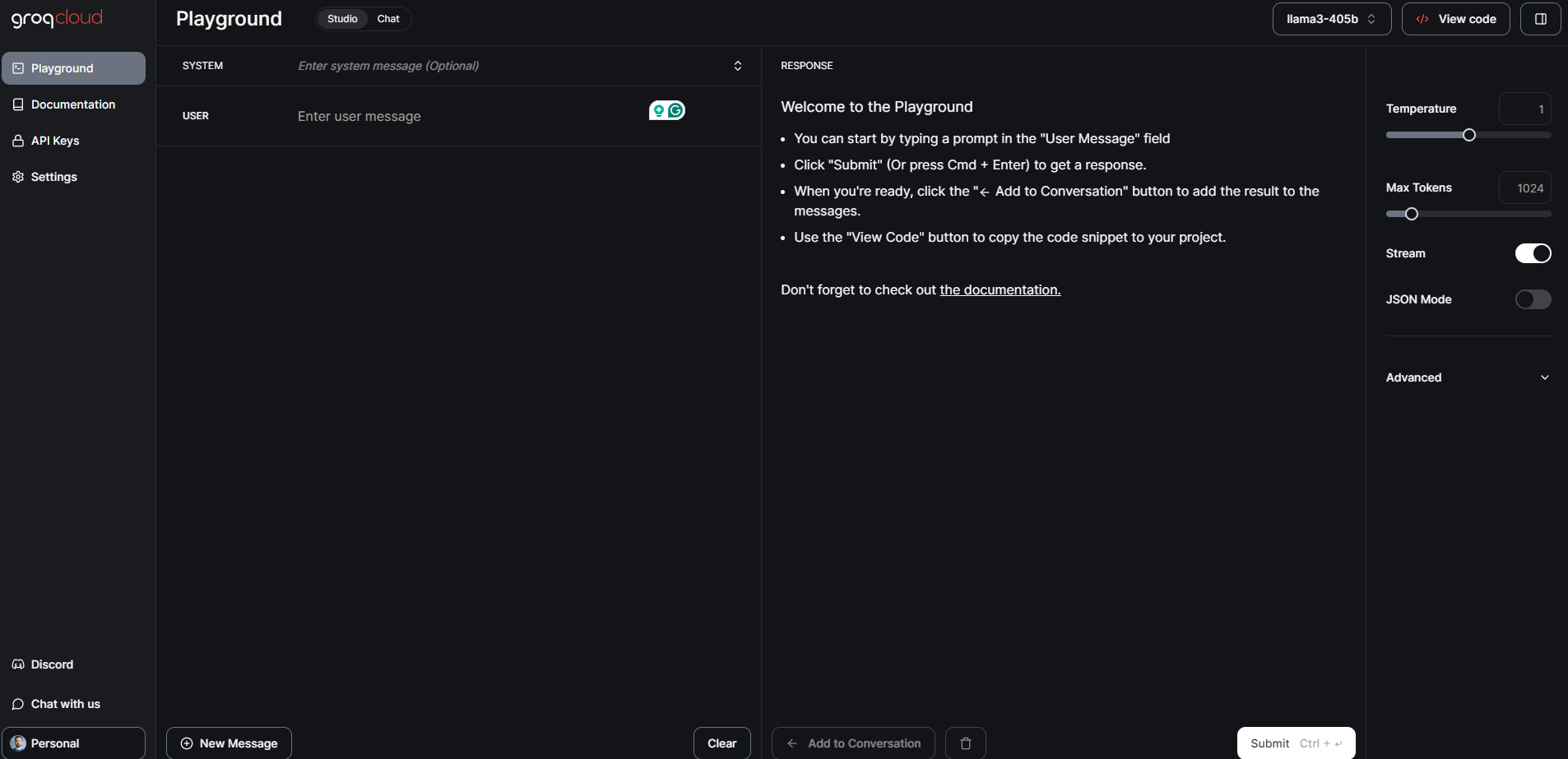

Meta Llama 3.1 405B, il modello di fondazione aperta più grande e più capace fino ad oggi, è ora disponibile su Groq. Questa guida ti guiderà attraverso i primi passi con Meta Llama 3.1 405B su Groq.

Passaggio 1: Console di sviluppo GroqCloud

- Iscriviti Accedi: Visitare il Console di sviluppo GroqCloud e registrati o accedi al tuo account.

- Trova modelli Meta Llama 3.1: Vai alla sezione modelli e cerca Meta Llama 3.1 405B. Troverai anche i modelli Instruct 70B e 8B disponibili.

- Ottieni una chiave API: Ottieni una chiave API Groq gratuita dalla console. Questa chiave ti consentirà di interagire con il modello.

GroqChat

Per l’accesso del pubblico generale, puoi utilizzare GroqChat:

- Visita GroqChat: Vai a GroqChat per interagire direttamente con Meta Llama 3.1 405B.

- Esplora le funzionalità: testare le capacità del modello in tempo reale, ad esempio generando testo, traduzioni o rispondendo a query.

Passaggio 2: configurazione dell’ambiente

Requisiti hardware e software

- Hardware: Assicurati di disporre di hardware adatto, preferibilmente GPU, per gestire i requisiti del modello.

- Software: Installa le dipendenze software necessarie come Python e PyTorch. Puoi trovare istruzioni di configurazione dettagliate sulla GroqCloud Dev Console.

Configurazione dell’ambiente

- Integrazione API: Sostituisci la tua attuale chiave API standard del settore con la chiave API Groq.

- Imposta URL di base: Configura la tua applicazione per utilizzare l’URL di base di Groq per le richieste API.

Fase 3: Caricamento ed esecuzione del modello

Caricamento del modello

- Frammenti di codice: Utilizza i frammenti di codice forniti sulla GroqCloud Dev Console per caricare Meta Llama 3.1 405B nella tua applicazione.

- Inizializzazione: Inizializza il modello con la chiave API e imposta tutti i parametri necessari per il tuo caso d’uso specifico.

Esecuzione dell’inferenza

- Inferenza in tempo reale: Inizia a eseguire l’inferenza in tempo reale inviando query al modello e ricevendo risposte.

- Elaborazione in lotti: Per attività più grandi, è possibile utilizzare l’elaborazione batch per gestire più query contemporaneamente.

Fase 4: messa a punto per attività specifiche

- Dati di formazione: Prepara il tuo set di dati per l’applicazione specifica per cui vuoi perfezionare il modello.

- Processo di messa a punto: Seguire le istruzioni dettagliate fornite da Meta e Groq per perfezionare il modello utilizzando tecniche supervisionate.

- Validazione: Convalidare il modello perfezionato per garantire che soddisfi i criteri di prestazione desiderati.

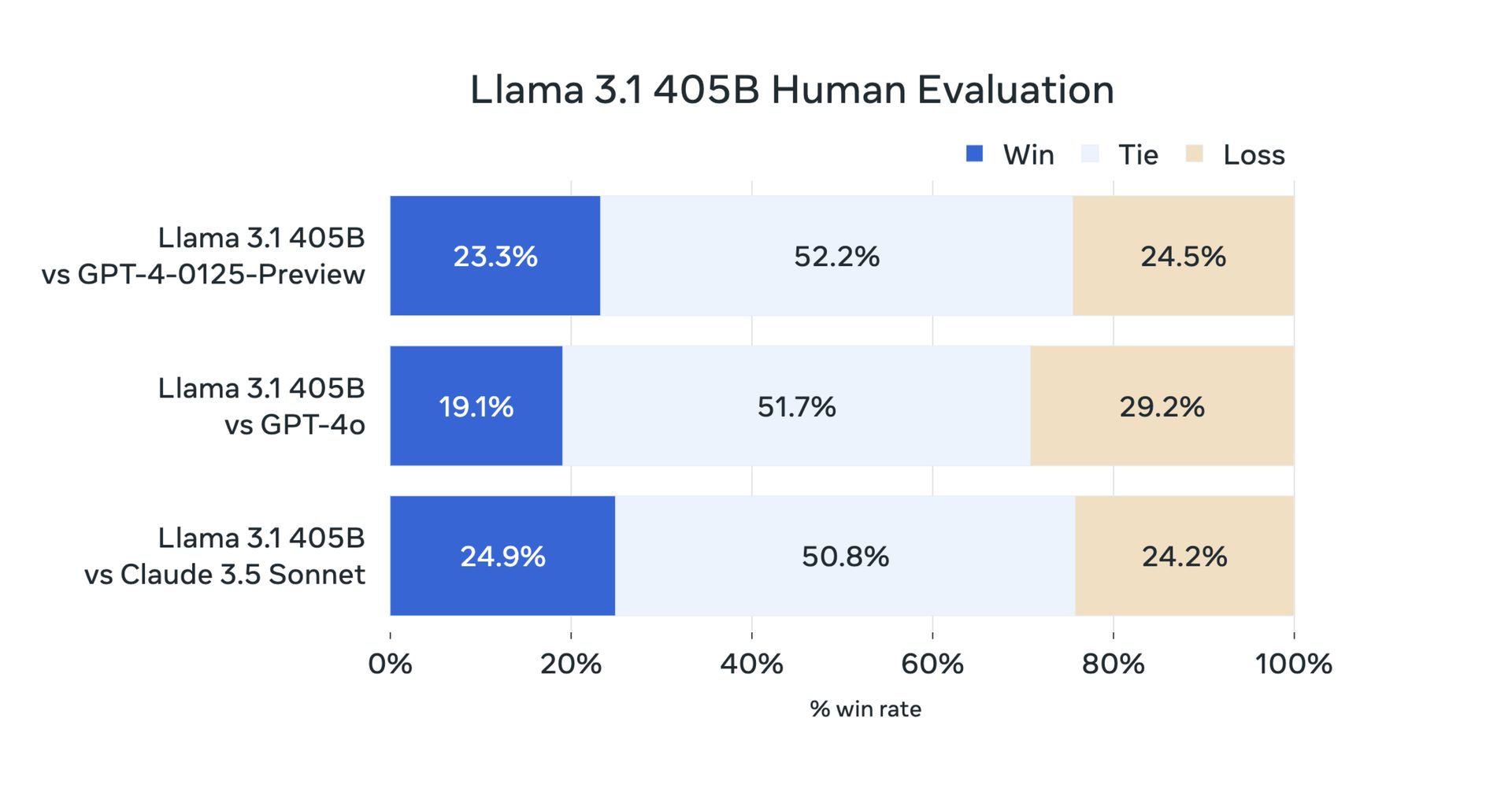

Meta Llama 3.1 405B: test di benchmark e prestazioni

Ieri, grazie alla sua natura open source, gli utenti hanno eseguito i loro test. Ma ora i test di benchmark ufficiali hanno confermato che Meta Llama 3.1 405B funziona eccezionalmente bene in una varietà di attività. Il modello è stato valutato su oltre 150 set di dati di benchmark e confrontato con modelli leader come GPT-4 e Claude 3.5 Sonnet. I risultati mostrano che Llama 3.1 405B è competitivo con questi modelli principali e offre prestazioni di alta qualità in scenari del mondo reale.

Innanzitutto, ecco i benchmark Llama 3.1 8B e Llama 3.1 70B:

| Categoria | Segno di riferimento | Lama 3.1 8B | Gemma 2 9B IT | Istruzione Mistral 7B | Lama 3.1 70B | Istruzioni Mixtral 8x22B | Motore GPT 3.5 Turbo |

|---|---|---|---|---|---|---|---|

| Generale | MMLU (0 colpi, CoT) | 73.0 | 72.3 | 60,5 | 86.0 | 79,9 | 69,8 |

| Generale | MMLU PRO (5 colpi, CoT) | 48.3 | – | 36.9 | 66,4 | 56.3 | 49.2 |

| Generale | Valutazione IFE | 80,4 | 73.6 | 57.6 | 87.5 | 72.7 | 69,9 |

| Codice | Valutazione umana (0 colpi) | 72.6 | 54.3 | 40.2 | 80,5 | 75,6 | 68.0 |

| Codice | MBPP EvalPlus (base) (0 colpi) | 72,8 | 71.7 | 49.5 | 86.0 | 78,6 | 82.0 |

| Matematica | GSM8K (8 colpi, CoT) | 84,5 | 76.7 | 53.2 | 95.1 | 88.2 | 81.6 |

| Matematica | MATEMATICA (0-tiro, CoT) | 51.9 | 44.3 | 13.0 | 68.0 | 54.1 | 43.1 |

| Ragionamento | Sfida ARC (0-tiro) | 83.4 | 87.6 | 74.2 | 94,8 | 88.7 | 83.7 |

| Ragionamento | GPQA (0-colpo, CoT) | 32.8 | – | 28,8 | 46.7 | 33.3 | 30.8 |

| Utilizzo degli strumenti | BFCL | 76.1 | – | 60,4 | 84,8 | – | 85,9 |

| Utilizzo degli strumenti | Nesso | 38.5 | 30.0 | 24.7 | 56.7 | 48.5 | 37.2 |

| Contesto lungo | ZeroSCROLLS/QUALITÀ | 81.0 | – | – | 90,5 | – | – |

| Contesto lungo | InfiniteBench/It.MC | 65.1 | – | – | 78.2 | – | – |

| Contesto lungo | NIH/Multi-ago | 98,8 | – | – | 97.5 | – | – |

| Multilingue | MGSM multilingue (0-shot) | 68,9 | 53.2 | 29.9 | 86,9 | 71.1 | 51.4 |

E c’è un benchmark Meta Llama 3.1 405B:

| Categoria | Segno di riferimento | Lama 3.1 405B | Nemotron 4 340B Istruzioni | GPT-4 (0125) | GPT-4 Omni | Claude 3.5 Sonetto |

|---|---|---|---|---|---|---|

| Generale | MMLU (0 colpi, CoT) | 88.6 | 78,7 (non CoT) | 85,4 | 88.7 | 88.3 |

| Generale | MMLU PRO (5 colpi, CoT) | 73.3 | 62.7 | 64,8 | 74.0 | 77.0 |

| Generale | Valutazione IFE | 88.6 | 85.1 | 84.3 | 85,6 | 88.0 |

| Codice | Valutazione umana (0 colpi) | 89.0 | 73.2 | 86,6 | 90.2 | 92.0 |

| Codice | MBPP EvalPlus (base) (0 colpi) | 88.6 | 72,8 | 83.6 | 87,8 | 90,5 |

| Matematica | GSM8K (8 colpi, CoT) | 96,8 | 92.3 (0 colpi) | 94.2 | 96.1 | 96.4 (0 colpi) |

| Matematica | MATEMATICA (0-tiro, CoT) | 73,8 | 41.1 | 64,5 | 76,6 | 71.1 |

| Ragionamento | Sfida ARC (0-tiro) | 96,9 | 94.6 | 96,4 | 96.7 | 96.7 |

| Ragionamento | GPQA (0-colpo, CoT) | 51.1 | – | 41.4 | 53.6 | 59,4 |

| Utilizzo degli strumenti | BFCL | 88,5 | 86,5 | 88.3 | 80,5 | 90.2 |

| Utilizzo degli strumenti | Nesso | 58.7 | – | 50.3 | 56.1 | 45.7 |

| Contesto lungo | ZeroSCROLLS/QUALITÀ | 95.2 | – | – | 90,5 | 90,5 |

| Contesto lungo | InfiniteBench/It.MC | 83.4 | – | 72.1 | 82.5 | – |

| Contesto lungo | NIH/Multi-ago | 98.1 | – | 100.0 | 100.0 | 90,8 |

| Multilingue | MGSM multilingue (0-shot) | 91.6 | – | 85,9 | 90,5 | 91.6 |

Meta Llama 3.1 405B rappresenta un progresso nell’intelligenza artificiale open source, offrendo a sviluppatori e ricercatori un potente strumento per una varietà di applicazioni. Con le sue funzionalità avanzate, un ecosistema robusto e l’impegno per uno sviluppo responsabile, speriamo che Llama 3.1 405B porti innovazioni alle comunità di intelligenza artificiale 70B e 8B. Ecco tutto ciò che abbiamo preparato per te.

Credito immagine in evidenza: Meta-IA

Source: Tutto quello che devi sapere su Meta Llama 3.1 405B