Costruire su Sussurroi ricercatori di Oxford stanno sviluppando WhisperX per un timestamp efficace a livello di parola in trascrizioni di discorsi di lunga durata.

A causa della disponibilità di vasti set di dati online, gli approcci formativi debolmente supervisionati e non supervisionati hanno dimostrato prestazioni eccezionali su una varietà di attività di elaborazione audio, tra cui voce riconoscimento, altoparlante riconoscimento, discorso separazioneE parola chiave spotting.

Come funzionano Whisper e WhisperX?

Whisper, un sistema di riconoscimento vocale creato da Ricercatori di Oxford, utilizza queste informazioni sostanziali su scala più ampia. Mostrano come il preaddestramento debolmente supervisionato di un trasformatore codificatore-decodificatore di base possa ottenere una trascrizione vocale multilingue a scatto zero su benchmark riconosciuti utilizzando 125.000 ore di dati di traduzione in inglese E 680.000 ore di dati rumorosi sull’addestramento vocale in 96 lingue aggiuntive.

Mentre la maggior parte dei benchmark accademici consiste in brevi dichiarazioni, in contesti del mondo reale come riunioni, podcast e video, è spesso necessaria la trascrizione di lunghi audio che possono durare ore o minuti.

Progetti di trasformatori impiegati in riconoscimento vocale automatico (ASR) non consentono la trascrizione di audio in ingresso arbitrariamente lungo (fino a 30 secondi nel caso di Whisper) a causa di vincoli di memoria.

La ricerca recente utilizza metodi euristici a finestra scorrevole, che sono soggetti a errori a causa di audio incompleto, dove alcune parole potrebbero mancare o essere trascritte in modo errato se si trovano all’inizio o alla fine del segmento di input; E sovrapposizione audioche può portare a trascrizioni incoerenti quando il modello elabora lo stesso discorso due volte.

Whisper presenta una tecnica di trascrizione bufferizzata che determina di quanto deve essere spostata la finestra di input basato su previsione accurata del timestamp. Tale metodo è suscettibile di gravi derive perché le imprecisioni del timestamp in una finestra potrebbero aggravarsi in problemi nelle finestre successive.

Usano una serie di euristiche fatte in casa per cercare di sradicare questi errori, anche se spesso non ci riescono. La decodifica collegata di Whisper, che utilizza un singolo codificatore-decodificatore per decodificare timestamp e trascrizioni, è soggetto ai soliti problemi con la generazione del linguaggio autoregressivoin particolare allucinazioni e ripetizioni.

Long-form e altre attività sensibili al timestamp come diarizzazione del parlante, lettura labialeE apprendimento audiovisivo ne sono influenzati negativamente, così come la trascrizione tamponata.

La carta dei sussurri afferma che una parte considerevole del corpus formativo è costituita da dati incompleti (accoppiamenti audio-trascrizione privi di informazioni di timestamp), indicati dal token |nottimestamps|>. L’esecuzione della trascrizione vocale viene involontariamente sacrificata timestamp meno accurato previsione durante il ridimensionamento su materiale di trascrizione imperfetto e rumoroso.

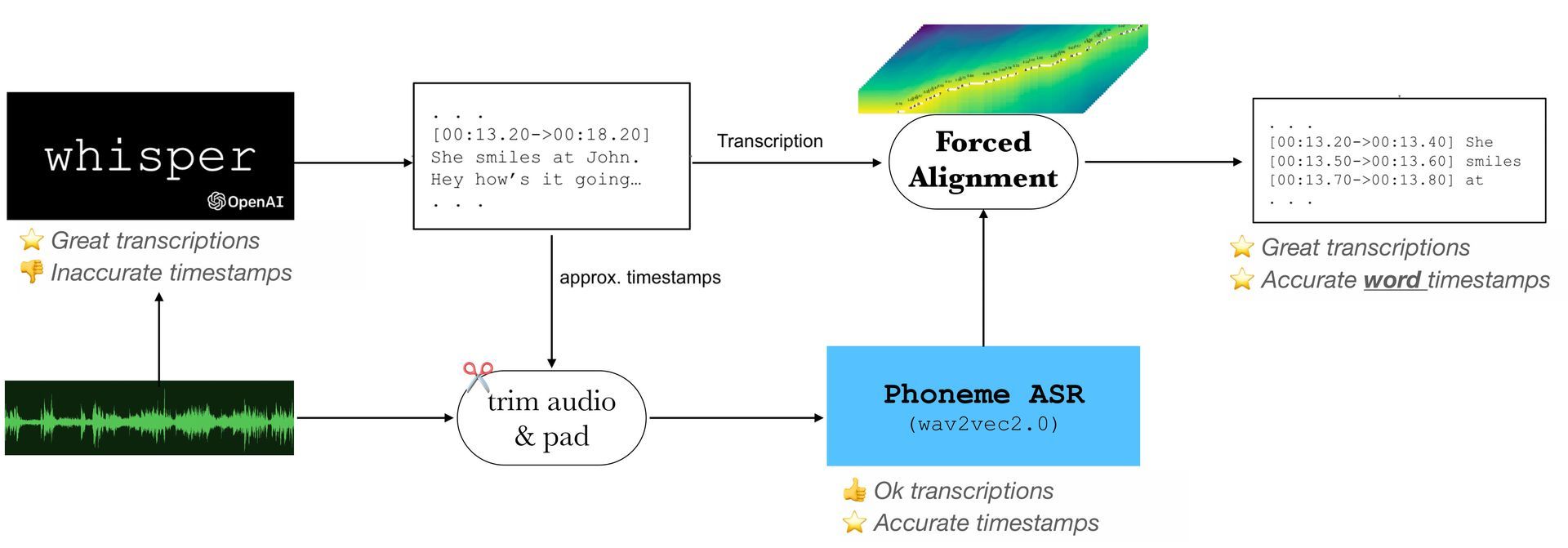

Di conseguenza, quando si utilizzano moduli aggiuntivi, il discorso e la trascrizione devono allinearsi correttamente. In “allineamento forzato“, la trascrizione del parlato e le forme d’onda audio sono sincronizzate a livello di parola o fonema. IL Modello di Markov nascosto (HMM) e il sottoprodotto di possibili allineamenti di stato sono spesso utilizzati nell’addestramento dei modelli di telefono acustico.

I modelli di correzione dei confini esterni vengono spesso utilizzati per correggere i timestamp di queste parole o numeri di telefono. A causa della rapida espansione di metodologie basate sul deep learningalcuni studi recenti utilizzano tecniche di deep learning per l’allineamento forzato, come l’applicazione di una matrice di attenzione bidirezionale o la segmentazione CTC con il modello addestrato end-to-end.

Un ulteriore miglioramento potrebbe essere ottenuto combinando un modello ASR all’avanguardia con un semplice modello di riconoscimento dei fonemi, entrambi costruiti utilizzando significativi set di dati su larga scala.

Quando WhisperX entra in scena

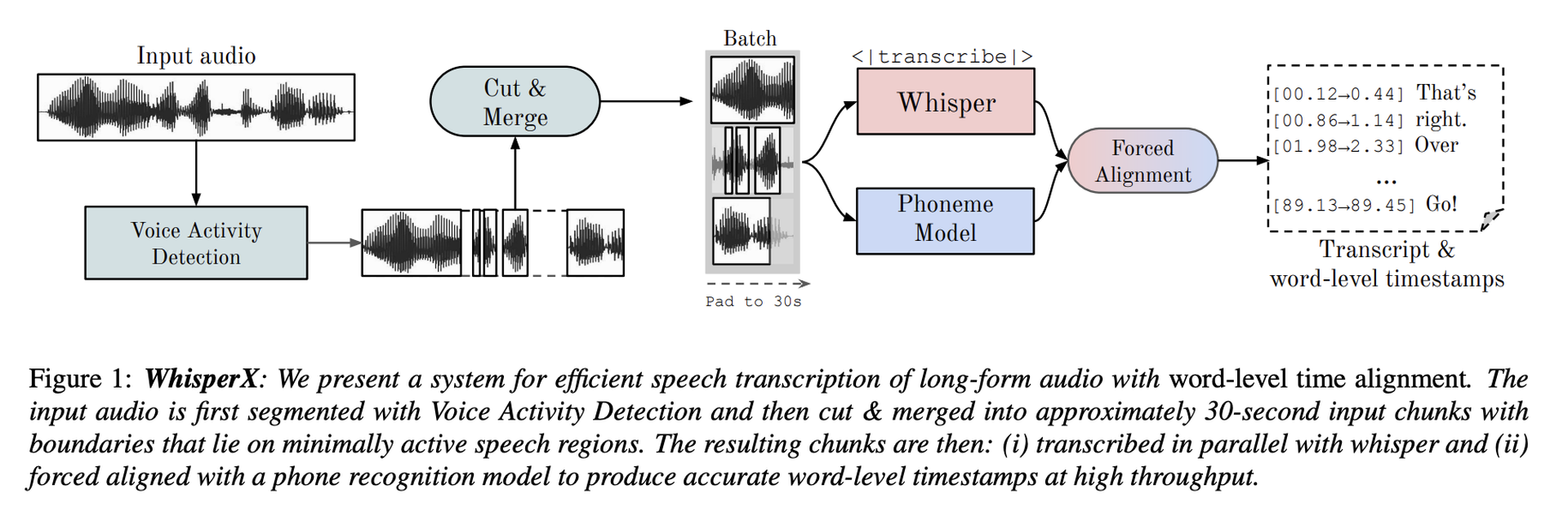

Propongono SussurroX, una tecnica per la trascrizione vocale accurata di registrazioni lunghe con timestamp precisi a livello di parola, come soluzione a questi problemi. Inoltre trascrizione sussurratacomprende anche le seguenti tre fasi:

- Utilizzo di un modello VAD (Voice Activity Detection) esterno per pre-segmentare l’audio in ingresso.

- I segmenti VAD risultanti vengono divisi e uniti in blocchi di input di circa 30 secondi con limiti sulle regioni vocali con la minore quantità di attività.

- Per fornire timestamp accurati a livello di parola, richiedono l’allineamento con un modello di fonema esterno.

Con l’ascesa dell’intelligenza artificiale e dei chatbot basati su testo, i programmi di sintesi vocale e di riconoscimento vocale sono molto richiesti. Proprio questa settimana, l’app di chat video ChatGPT Call Annie AI è stata rilasciata nel tentativo di capitalizzare questa crescente domanda. Sebbene il futuro di WhisperX non sia ancora del tutto chiaro per quanto riguarda le sue possibilità, potremmo dire che vale sicuramente la pena tenere traccia dei suoi progressi.

Source: Whisper e WhisperX: sistema di trascrizione vocale accurato nel tempo dai ricercatori di Oxford